7 月 3 日消息,meta 公司昨日(7 月 2 日)发布研究论文,介绍了名为 meta 3d gen(3dgen)的全新 ai 模型,可以在 1 分钟内基于用户输入的提示词,生成高质量的 3d 内容。

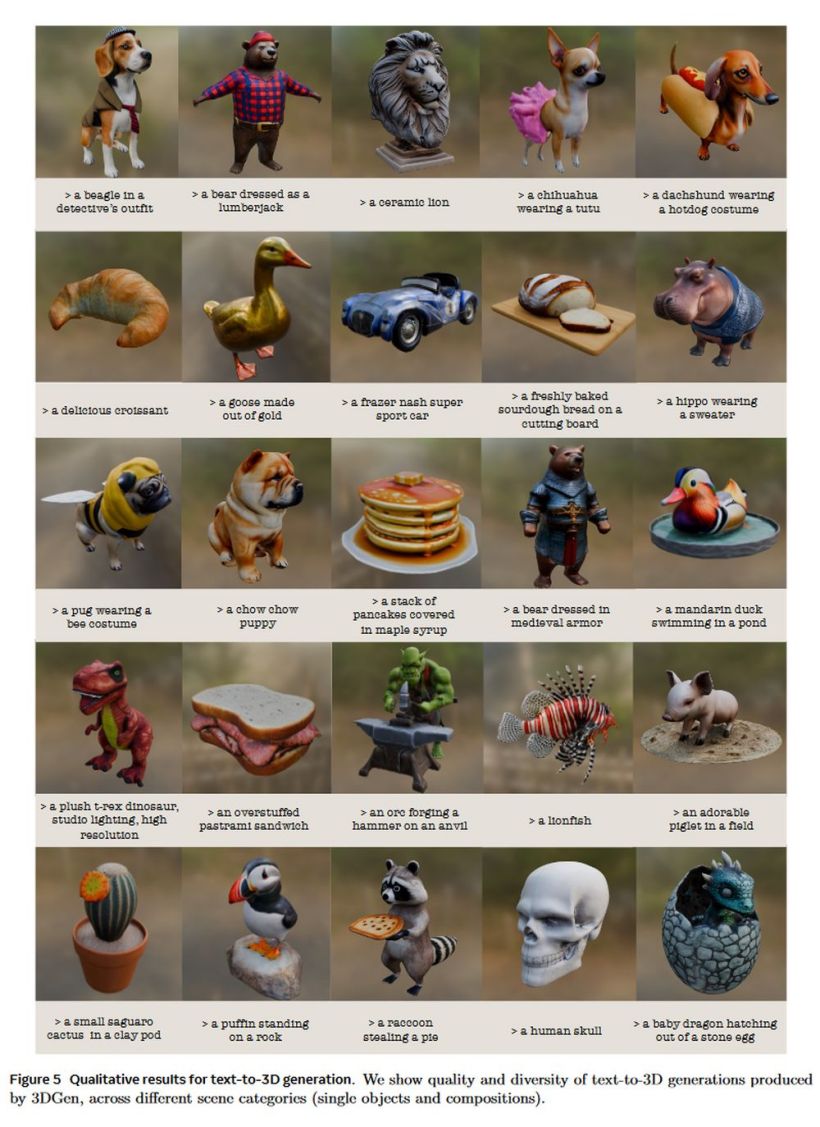

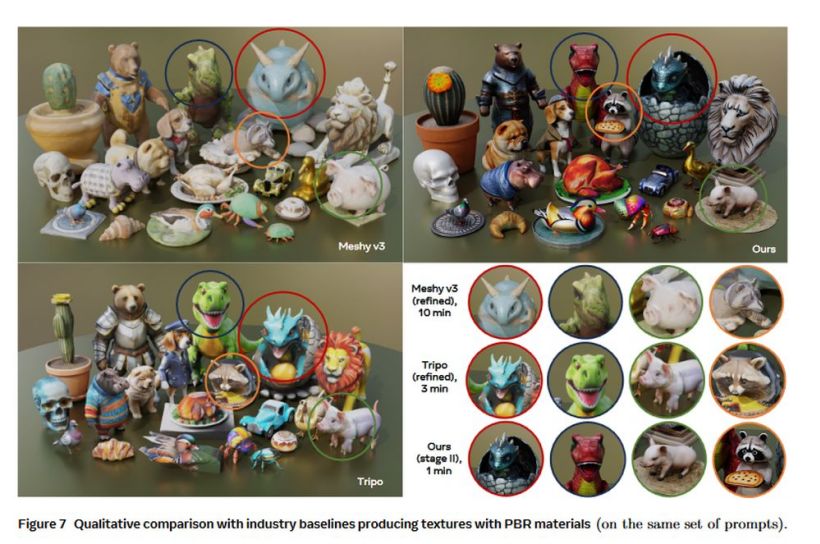

meta 公司表示 meta 3d gen(3dgen)所生成的 3d 内容具备高分辨率纹理和材质贴图,还支持基于物理的渲染(pbr),并能对此前生成的 3d 内容重新再生成新纹理。

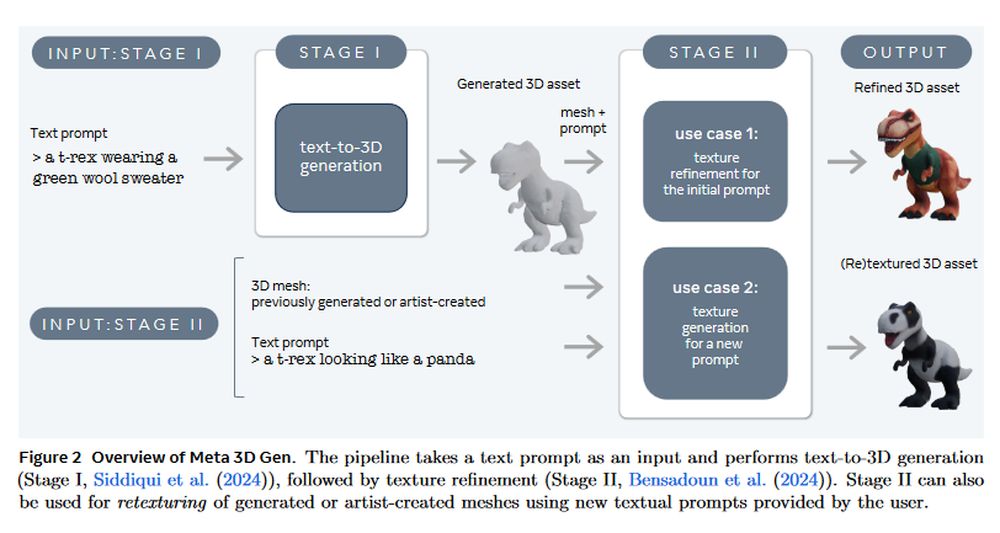

代码网援引论文主要内容,meta 3d gen 包含 text-to-3d 生成和 text-to-texture 生成两个主要组件,其工作原理如下:

第一阶段

根据用户提供的文本提示,第一阶段使用 meta 的三维资产生成模型(assetgen)创建初始 3d 资产。该步骤生成一个带有纹理和 pbr 材质贴图的 3d mesh。推理时间约为 30 秒。

第二阶段

案例 1:生成更细化的 3d 纹理

根据阶段 1 生成的三维资产和初始文本提示,阶段 2 将为该资产生成更高质量的纹理和 pbr 贴图。它使用 meta 的文本到纹理生成器 meta 3d texturegen。推理时间约为 20 秒。

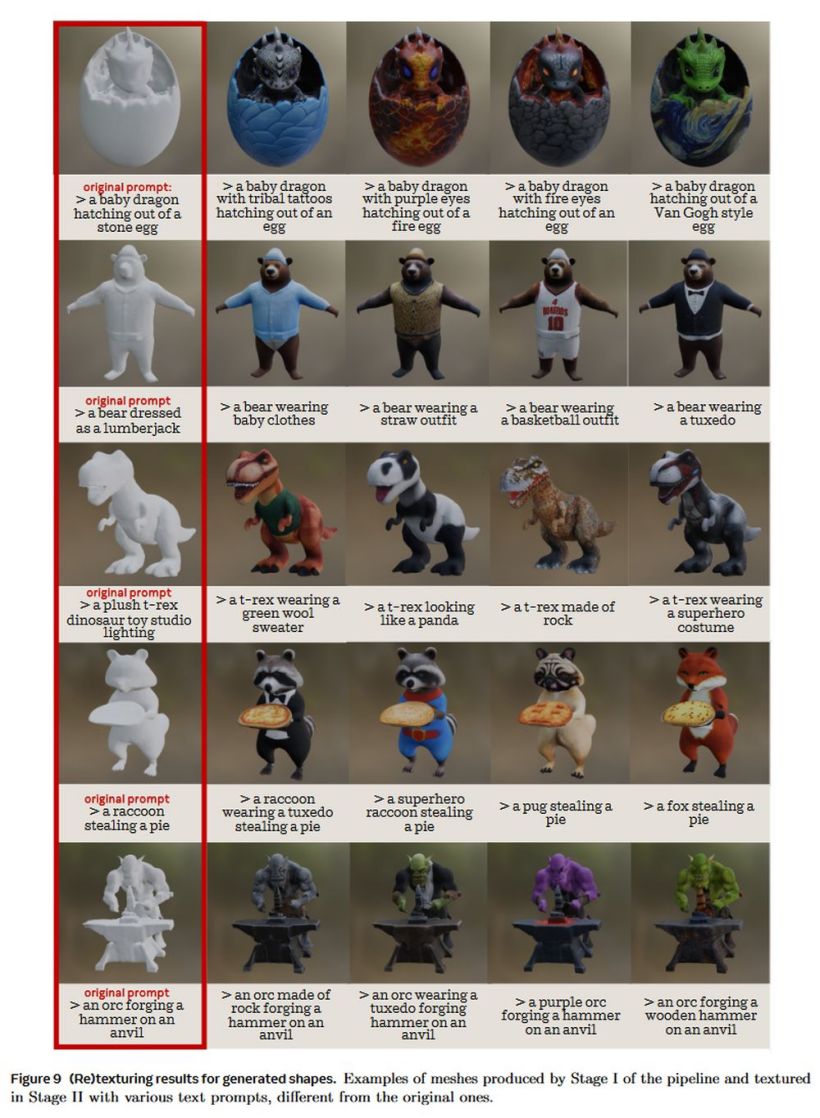

案例 2:再生成 3d 纹理

给定一个未纹理化的 3d mesh 和一个描述其所需外观的提示。阶段 2 还可以从头开始为该三维资产生成纹理(mesh 可以是以前生成的,也可以是艺术家创建的)。推理时间约为 20 秒。

代码网附上完整报告链接,感兴趣的用户可以深入阅读。

发表评论