6 月 7 日消息,通义千问(qwen)今天宣布经过数月的努力,qwen 系列模型从 qwen1.5 到 qwen2 的重大升级,并已在 hugging face 和 modelscope 上同步开源。

代码网附上 qwen 2.0 主要内容如下:

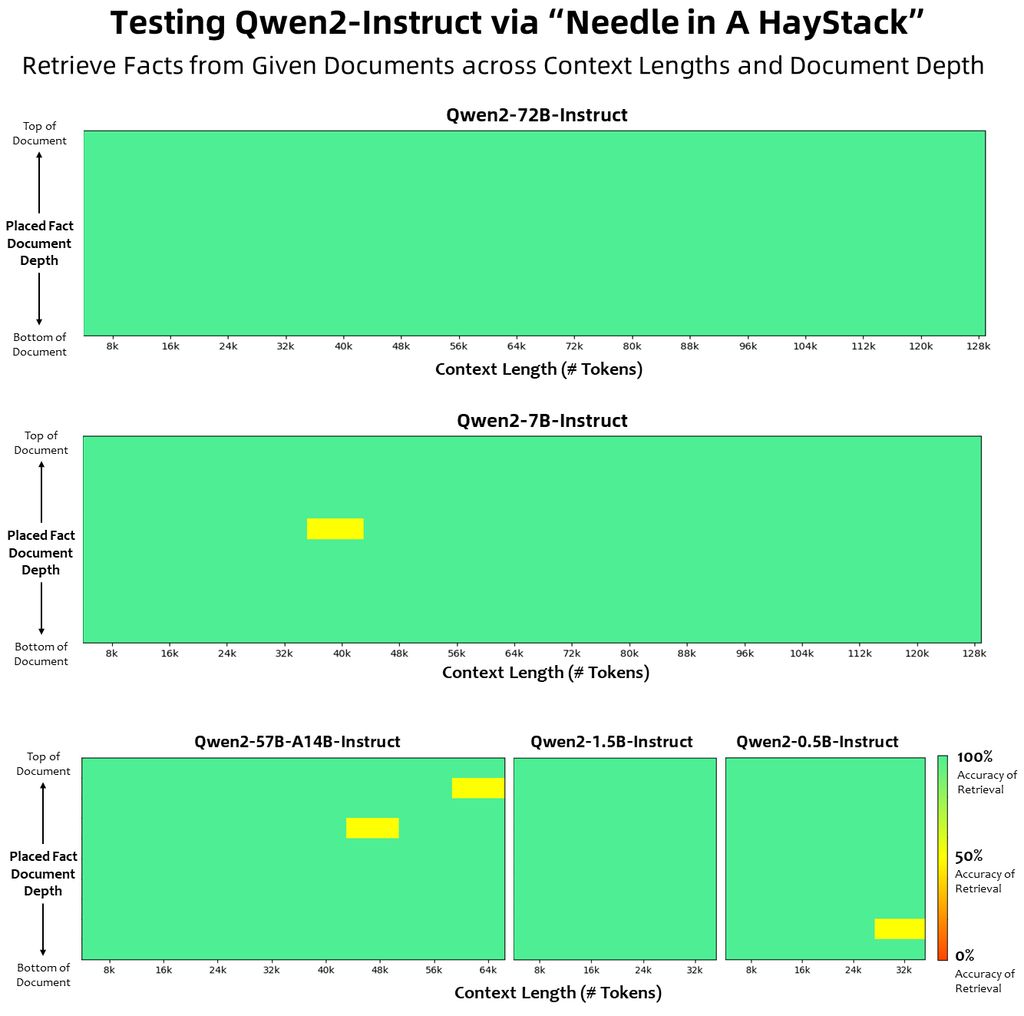

5 个尺寸的预训练和指令微调模型,包括 qwen2-0.5b、qwen2-1.5b、qwen2-7b、qwen2-57b-a14b 以及 qwen2-72b

在中文英语的基础上,训练数据中增加了 27 种语言相关的高质量数据;

多个评测基准上的领先表现;

代码和数学能力显著提升;

增大了上下文长度支持,最高达到 128k tokens(qwen2-72b-instruct)。

模型基础信息

qwen2 系列包含 5 个尺寸的预训练和指令微调模型,其中包括 qwen2-0.5b、qwen2-1.5b、qwen2-7b、qwen2-57b-a14b 和 qwen2-72b。

| 模型 | qwen2-0.5b | qwen2-1.5b | qwen2-7b | qwen2-57b-a14b | qwen2-72b |

|---|---|---|---|---|---|

| 参数量 | 0.49b | 1.54b | 7.07b | 57.41b | 72.71b |

| 非 embedding 参数量 | 0.35b | 1.31b | 5.98b | 56.32b | 70.21b |

| gqa | true | true | true | true | true |

| tie embedding | true | true | false | false | false |

| 上下文长度 | 32k | 32k | 128k | 64k | 128k |

在 qwen1.5 系列中,只有 32b 和 110b 的模型使用了 gqa。这一次,所有尺寸的模型都使用了 gqa,以便让大家体验到 gqa 带来的推理加速和显存占用降低的优势。

模型评测

相比 qwen1.5,qwen2 在大规模模型实现了非常大幅度的效果提升。我们对 qwen2-72b 进行了全方位的评测。

在针对预训练语言模型的评估中,对比当前最优的开源模型,qwen2-72b 在包括自然语言理解、知识、代码、数学及多语言等多项能力上均显著超越当前领先的模型,如 llama-3-70b 以及 qwen1.5 最大的模型 qwen1.5-110b。

代码网附上参考地址

发表评论