6 月 3 日消息,昆仑万维今日宣布开源 2 千亿稀疏大模型 skywork-moe,基于之前昆仑万维开源的 skywork-13b 模型中间 checkpoint 扩展而来,号称是首个完整将 moe upcycling 技术应用并落地的开源千亿 moe 大模型,也是首个支持用单台 rtx 4090 服务器(8 张 rtx 4090 显卡)推理的开源千亿 moe 大模型。

据介绍,本次开源的 skywork-moe 模型隶属于天工 3.0 的研发模型系列,是其中的中档大小模型(skywork-moe-medium),模型的总参数量为 146b,激活参数量 22b,共有 16 个 expert,每个 expert 大小为 13b,每次激活其中的 2 个 expert。

天工 3.0 还训练了 75b (skywork-moe-small) 和 400b (skywork-moe-large)两档 moe 模型,并不在此次开源之列。

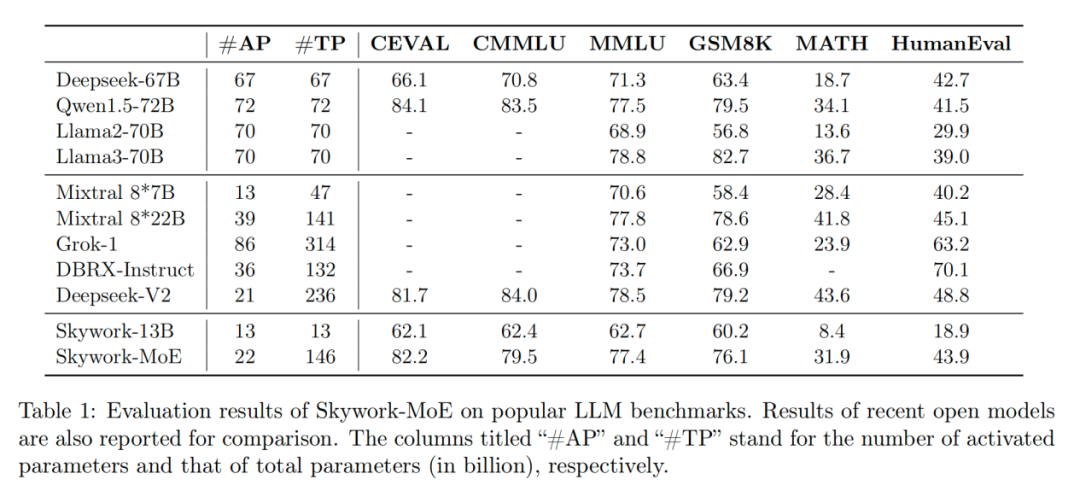

根据官方测试,在相同的激活参数量 20b(推理计算量)下,skywork-moe 能力接近 70b 的 dense 模型,使得模型的推理成本有近 3 倍的下降。同时 skywork-moe 的总参数大小比 deepseekv2 的总参数大小要小 1/3,用更小的参数规模做到了相近的能力。

skywork-moe 的模型权重、技术报告完全开源,免费商用,无需申请,代码网附链接如下:

模型权重下载:

https://huggingface.co/skywork/skywork-moe-base

https://huggingface.co/skywork/skywork-moe-base-fp8

模型技术报告:https://github.com/skyworkai/skywork-moe/blob/main/skywork-moe-tech-report.pdf

模型推理代码:(支持 8 x 4090 服务器上 8 bit 量化加载推理) https://github.com/skyworkai/vllm

发表评论