方法一. 利用pytorch自身

pytorch是一个流行的深度学习框架,它允许研究人员和开发者快速构建和训练神经网络。计算一个pytorch网络的参数量通常涉及两个步骤:确定网络中每个层的参数数量,并将它们加起来得到总数。

以下是在pytorch中计算网络参数量的一般方法:

定义网络结构:首先,你需要定义你的网络结构,通常通过继承

torch.nn.module类并实现一个构造函数来完成。计算单个层的参数量:对于网络中的每个层,你可以通过检查层的

weight和bias属性来计算参数量。例如,对于一个全连接层(torch.nn.linear),它的参数量由输入特征数、输出特征数和偏置项决定。遍历网络并累加参数:使用一个循环遍历网络中的所有层,并累加它们的参数量。

考虑非参数层:有些层可能没有可训练参数,例如激活层(如relu)。这些层虽然对网络功能至关重要,但对参数量的计算没有贡献。

下面是一个示例代码,展示如何计算一个简单网络的参数量:

import torch

import torch.nn as nn

class simplenet(nn.module):

def __init__(self):

super(simplenet, self).__init__()

self.fc1 = nn.linear(10, 20) # 10个输入特征到20个输出特征的全连接层

self.fc2 = nn.linear(20, 30) # 20个输入特征到30个输出特征的全连接层

# 假设还有一个relu激活层,但它没有参数

def forward(self, x):

x = self.fc1(x)

x = torch.relu(x) # 激活层

x = self.fc2(x)

return x

# 实例化网络

net = simplenet()

# 计算总参数量

total_params = sum(p.numel() for p in net.parameters() if p.requires_grad)

print(f'total number of parameters: {total_params}')

在这个例子中,numel()函数用于计算张量中元素的数量,requires_grad=true确保只计算那些需要在反向传播中更新的参数。

请注意,这个示例只计算了网络中需要梯度的参数,也就是那些可训练的参数。如果你想要计算所有参数,包括那些不需要梯度的,可以去掉if p.requires_grad的条件。

方法二. 利用torchsummary

在pytorch中,可以使用torchsummary库来计算神经网络的参数量。首先,确保已经安装了torchsummary库:

pip install torchsummary

然后,按照以下步骤计算网络的参数量:

- 导入所需的库和模块:

import torch from torchsummary import summary

- 定义网络模型:

class net(torch.nn.module):

def __init__(self):

super(net, self).__init__()

self.conv1 = torch.nn.conv2d(3, 64, kernel_size=3, stride=1, padding=1)

self.conv2 = torch.nn.conv2d(64, 128, kernel_size=3, stride=1, padding=1)

self.fc1 = torch.nn.linear(128 * 32 * 32, 256)

self.fc2 = torch.nn.linear(256, 10)

def forward(self, x):

x = torch.nn.functional.relu(self.conv1(x))

x = torch.nn.functional.relu(self.conv2(x))

x = x.view(-1, 128 * 32 * 32)

x = torch.nn.functional.relu(self.fc1(x))

x = self.fc2(x)

return x

model = net()

- 使用

summary函数计算参数量:

summary(model, (3, 32, 32))

这里的(3, 32, 32)是输入数据的形状,根据实际情况进行修改。

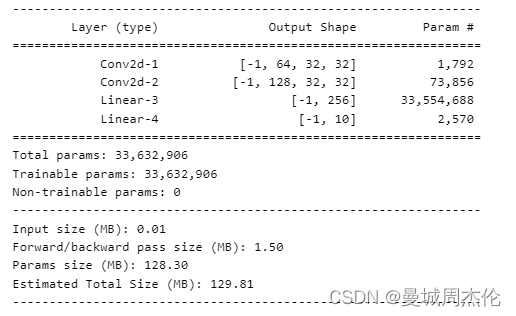

运行以上代码后,将会输出网络的结构以及每一层的参数量和总参数量。

到此这篇关于pytorch计算网络参数的两种方法的文章就介绍到这了,更多相关pytorch计算网络参数内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论