远程连接方案,允许程序员连接远端测试环境,确保环境的统一,避免各种环境问题的发生,而且由于是连接的远程环境,所有在pycharm编写的代码 可自动上传到远端服务器,本地在执行代码的时候,相当于直接在远端环境上运行。

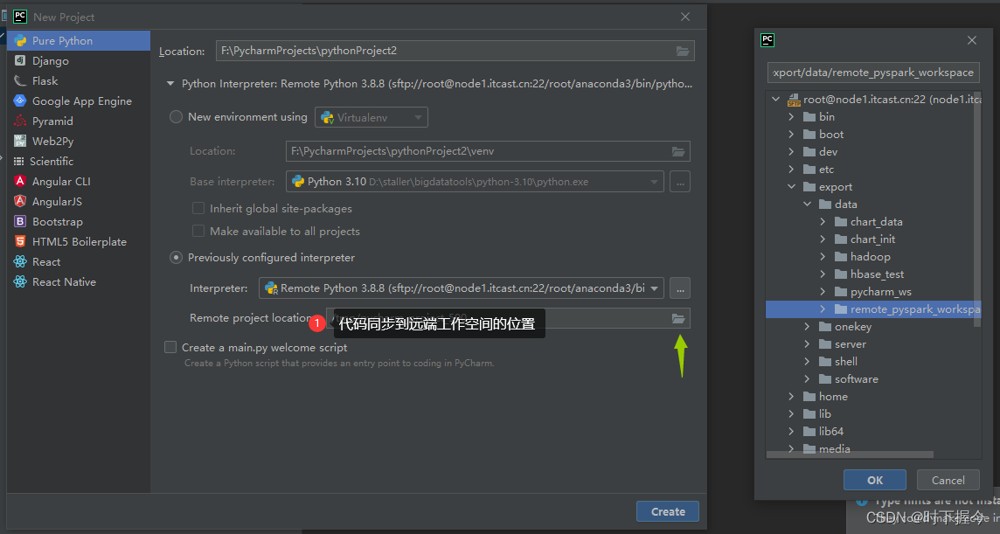

1. 创建工程,指定远端python解析器

前提条件:远端centos系统,安装了spark环境,安装了python环境,本文基于anaconda安装的python环境

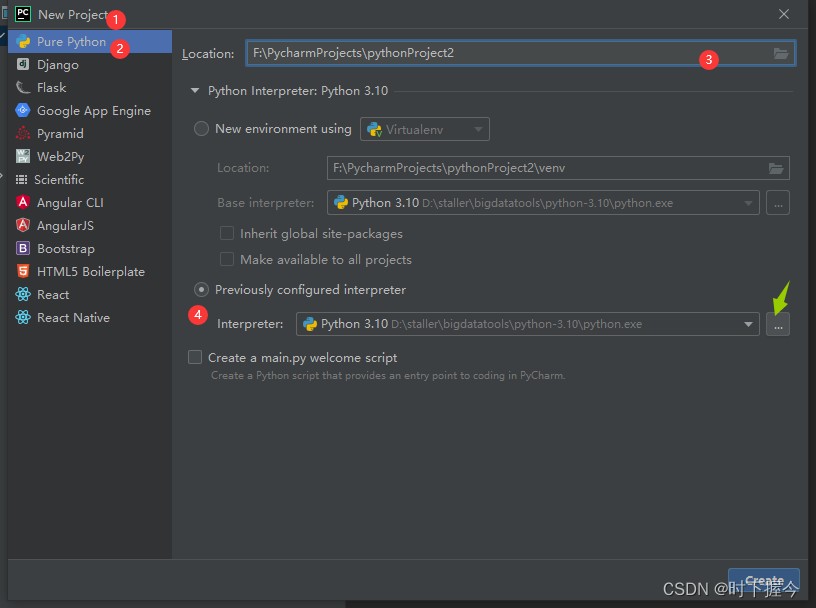

打开pycharm开发工具,选择file->new project->pure python创建一个python工程

需要:指定工程本地工作目录,选择先前配置的python解析器,若未配置远端python解析器,则打开对话框根据提示配置

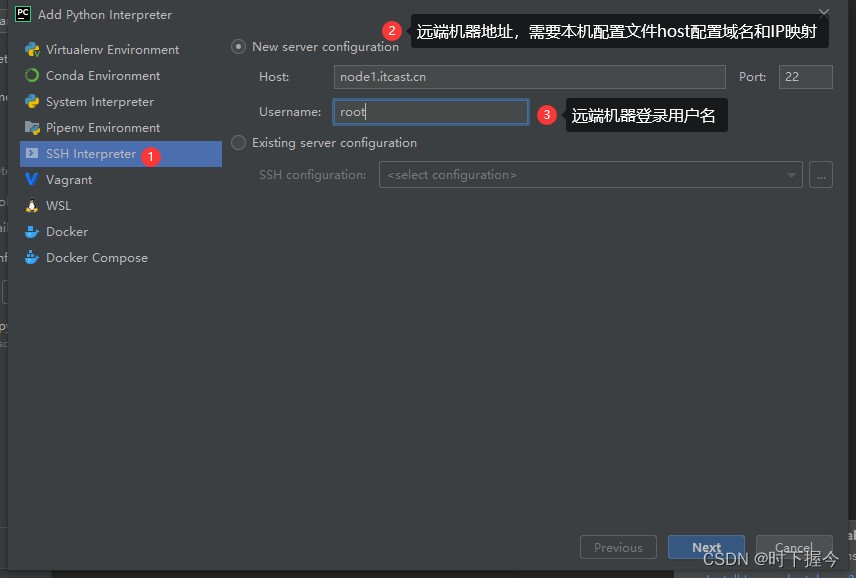

2. 添加远端python解析器

添加远端python解析器,需要ssh方式(指定服务器地址、登录用户名、登录口令)登录远端服务器

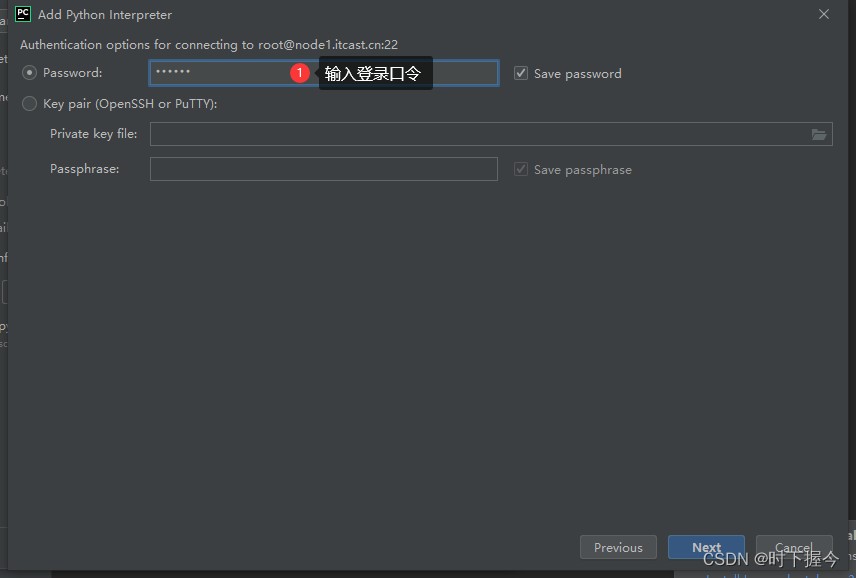

指定服务器的登录口令

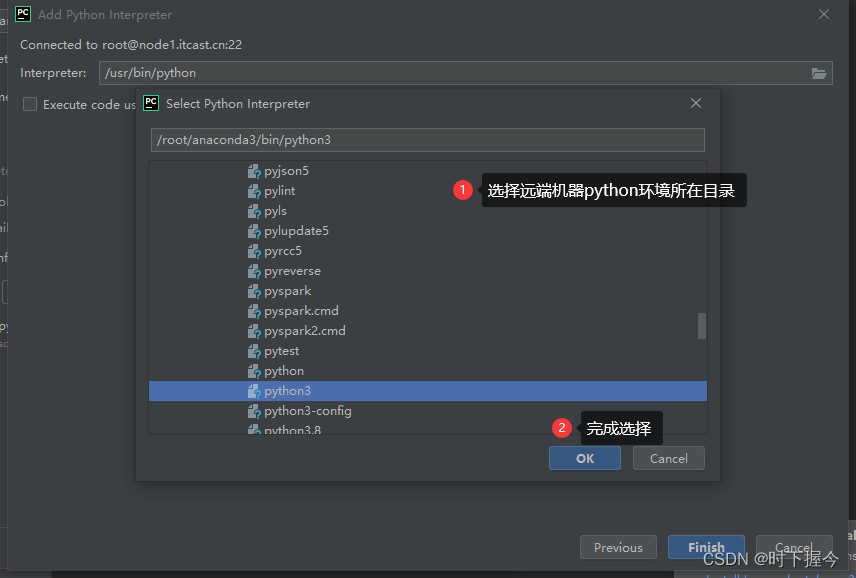

单机 next,连接到服务器后,选择python的安装目录

配置完成,就可以选择已经配置了的服务器python解析器。

同时指定工程在服务器上的工作目录

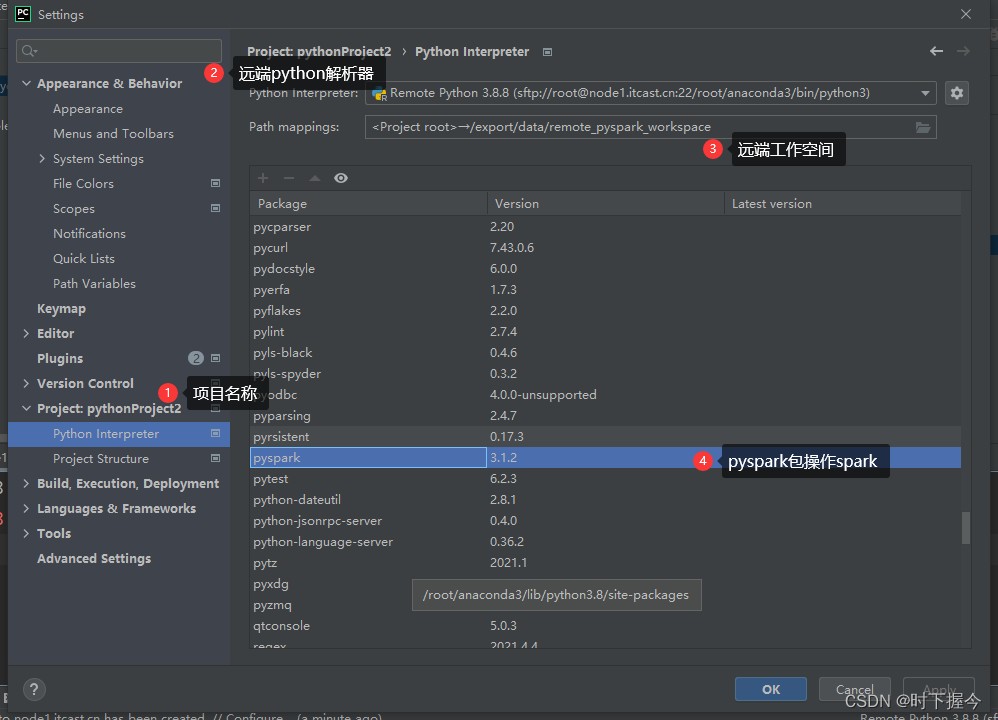

3. 配置完成

配置完成,file->settings -> 选择对应工程,可以发现:服务器上python环境安装的工具包,及本地工作目录和服务器工作目录的映射。这里主要关注pyspark包的安装

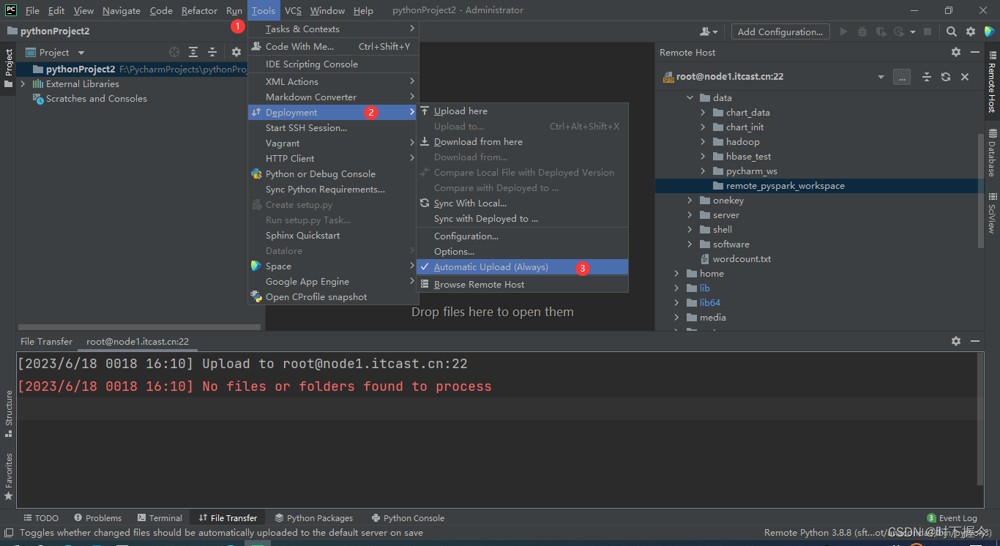

4. 本地文件自动同步远端

本地工程文件实时同步到服务器工作目录,若担心影响开发效率,可以关闭自动同步,开启手工同步

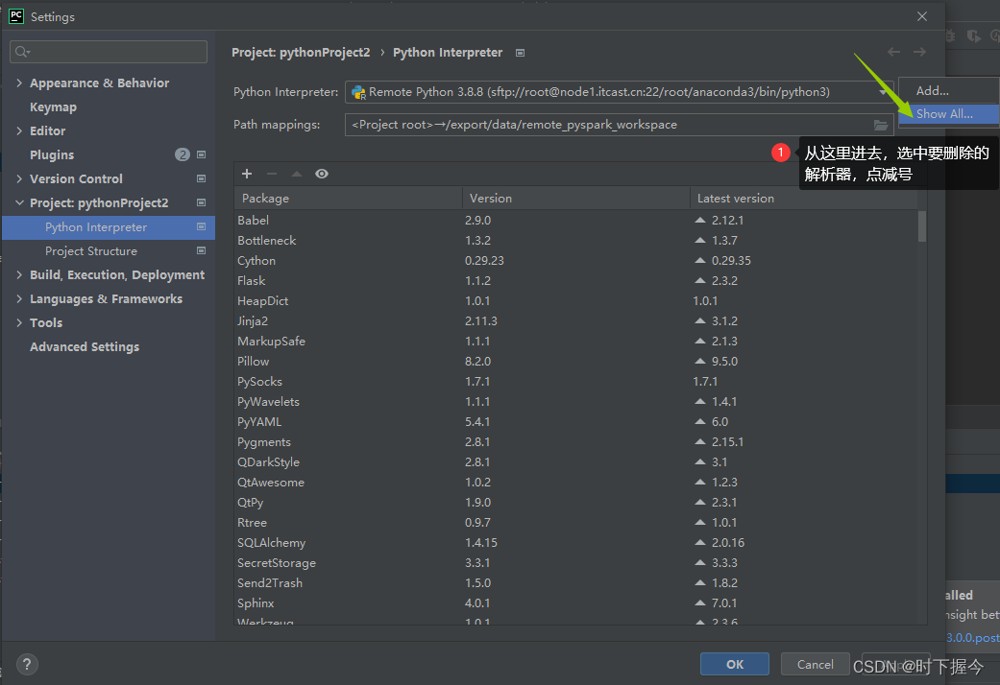

5. 删除远端python解析器(非必须操作,重新配置时参考该项)

配置过程中,若发现服务器python解析器配置错误,或配置重复,可从此处进入,删除有误的配置

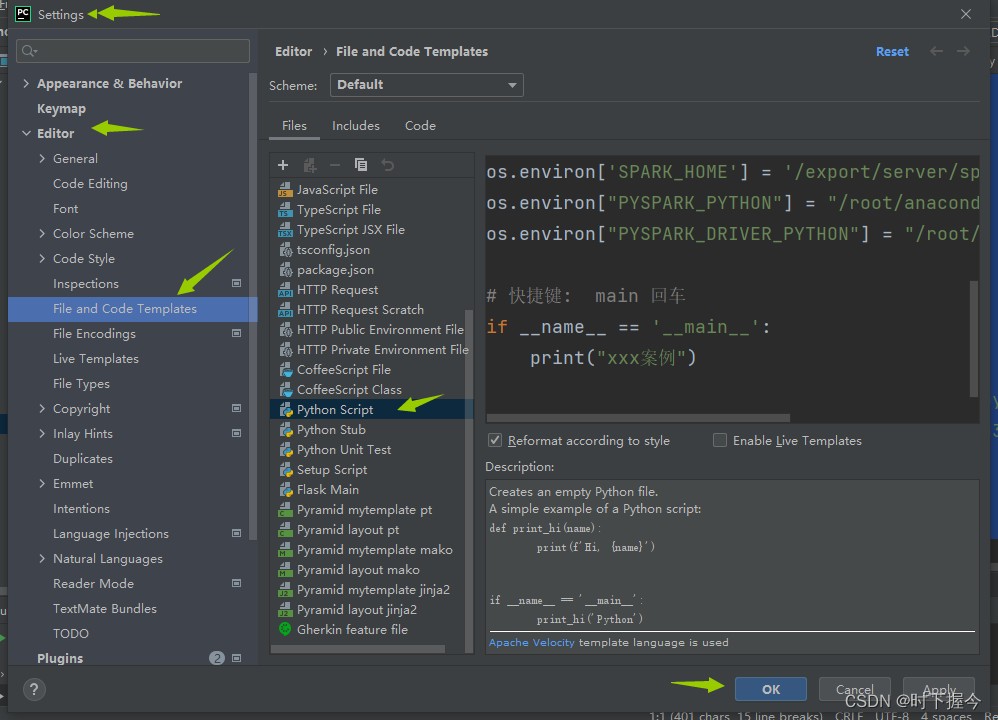

6. 文件模板配置

每个文件都用到的一些代码,例如导包,本地锁定服务器python解析器,可以做成一个模板。工程中每次创建一个新文件,会自动导入模板。

#!/usr/bin/env python

# @desc :

__coding__ = "utf-8"

__author__ = "xxx team"

from pyspark import sparkcontext, sparkconf

import os

# 锁定远端操作环境, 避免存在多个版本环境的问题

os.environ['spark_home'] = '/export/server/spark'

os.environ["pyspark_python"] = "/root/anaconda3/bin/python"

os.environ["pyspark_driver_python"] = "/root/anaconda3/bin/python"

# 快捷键: main 回车

if __name__ == '__main__':

print("xxx案例")

总结

以上为个人经验,希望能给大家一个参考,也希望大家多多支持代码网。

发表评论