redis 是一种高性能的键值存储系统,广泛用于实现缓存功能。它通过将数据存储在内存中,能够快速读写数据,从而显著提高应用程序的性能。在redis中实现缓存功能需要结合数据读写策略、失效机制及性能优化方案。

一、redis作为缓存的核心优势

高性能读写:内存存储+单线程架构,支持10万+qps。

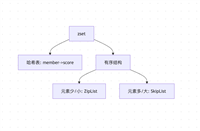

丰富数据结构:string(最常用)、hash、list等适配不同场景。

过期机制:自动淘汰过期数据,减少内存占用。

高可用性:通过哨兵(sentinel)或集群(cluster)实现故障转移。

二、redis缓存实现核心流程

1. 基础缓存读写模型(cache-aside模式)

import redis

import time

from functools import wraps

# 连接redis

redis_client = redis.redis(host='localhost', port=6379, db=0)

def get_data_from_cache_or_db(key, db_query_func, cache_ttl=3600):

"""从缓存获取数据,若不存在则查询数据库并写入缓存"""

# 读缓存

cache_data = redis_client.get(key)

if cache_data:

return cache_data.decode('utf-8') # 反序列化

# 缓存未命中,查询数据库

db_data = db_query_func()

if db_data:

# 写入缓存(设置过期时间)

redis_client.setex(key, cache_ttl, db_data)

return db_data

# 示例:查询用户信息

def get_user_info(user_id):

def query_db():

# 实际项目中调用数据库查询

return f"user:{user_id}:info"

return get_data_from_cache_or_db(f"user:{user_id}", query_db)

2. 缓存更新策略

redis主要采用以下的缓存更新策略:

过期淘汰(推荐):通过expire或setex设置ttl,适用于非实时数据。

主动更新:数据变更时同步更新缓存(需注意并发问题)。

懒加载更新:下次读取时刷新缓存(如上述代码)。

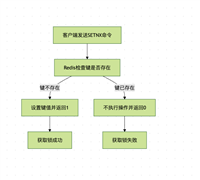

3. 并发场景处理(防缓存击穿)

def cache_with_lock(key, db_func, lock_ttl=10, cache_ttl=3600):

"""使用分布式锁避免缓存击穿(多个请求同时查询数据库)"""

lock_key = f"lock:{key}"

# 尝试获取锁(setnx:仅当key不存在时设置)

acquired = redis_client.set(

lock_key,

"1",

nx=true, # 不存在时才设置

ex=lock_ttl # 锁过期时间,防止死锁

)

if acquired:

try:

# 锁获取成功,查询数据库

data = db_func()

if data:

redis_client.setex(key, cache_ttl, data)

return data

finally:

# 释放锁(确保原子性,避免误删其他线程的锁)

redis_client.delete(lock_key)

else:

# 锁被占用,等待重试或直接返回缓存(若有)

time.sleep(0.1) # 短暂休眠后重试

return redis_client.get(key)三、缓存常见问题及解决方案

| 问题类型 | 问题描述 | 影响 | 解决方案 | 技术实现要点 | 适用场景 | 性能影响 | 一致性级别 |

|---|---|---|---|---|---|---|---|

| 缓存穿透 | 大量请求查询不存在的key,穿透缓存直达数据库 | 数据库压力骤增,可能导致服务崩溃 | 1. 布隆过滤器(bloom filter) 2. 缓存空值(null值缓存) | 1. 布隆过滤器预加载所有可能的key 2. 缓存空值设置短ttl(如60秒) | 高并发且查询key分散的场景 | 1. 布隆过滤器增加约0.5ms延迟 2. 空值缓存增加内存占用 | 最终一致性(空值可能短暂存在) |

| 缓存雪崩 | 大量缓存key在同一时间过期,导致请求全部转向数据库 | 数据库瞬时压力过大,服务响应缓慢甚至不可用 | 1. 随机化ttl(基础时间+随机偏移) 2. 热点数据永不过期(手动更新) | 1. ttl=基础时间(如3600秒)+随机数(0-600秒) 2. 定期后台线程更新热点数据 | 有明确批量缓存更新的场景 | 随机化ttl可能导致部分缓存提前过期,增加数据库访问频率 | 最终一致性(热点数据手动更新时可能不一致) |

| 缓存击穿 | 单个热点key过期时,大量请求同时查询该key,导致数据库压力激增 | 数据库瞬间压力过大,可能引发连锁反应 | 1. 分布式锁(如redlock) 2. 互斥更新(仅允许一个请求更新缓存) | 1. 使用setnx+expire原子操作实现锁 2. 锁超时时间设置为业务处理时间的2倍 | 热点key访问频率极高的场景(如秒杀商品) | 加锁操作增加约1-3ms延迟,可能导致部分请求等待 | 强一致性(锁持有期间) |

| 缓存与数据库不一致 | 缓存与数据库数据不一致,可能导致业务逻辑错误 | 数据展示异常,业务计算结果错误 | 1. 延时双删(先删缓存,更新数据库,延迟后再删缓存) 2. 消息队列异步同步 | 1. 延迟时间设置为主从复制延迟的2倍(如500ms) 2. 消息队列保证至少一次投递 | 对数据一致性要求较高的场景(如库存、余额) | 延时双删增加约1ms延迟,消息队列增加约50-100ms异步延迟 | 最终一致性(延时双删)/ 强一致性(消息队列同步成功后) |

| 缓存污染 | 冷门数据占用缓存空间,导致热点数据被淘汰 | 缓存命中率下降,频繁访问数据库 | 1. 使用lfu(最不经常使用)淘汰策略 2. 定期清理冷门数据 | 1. 配置maxmemory-policy=allkeys-lfu 2. 基于访问频率设置数据优先级 | 数据访问分布不均,有明显冷热数据区分的场景 | lfu算法比lru略消耗cpu资源(约5%) | n/a |

| 缓存失效风暴 | 当某个key失效时,大量请求同时重建缓存,造成系统资源浪费 | cpu、内存资源被过度占用,服务响应缓慢 | 1. 永不过期(逻辑过期) 2. 后台异步更新缓存 | 1. 缓存不设置物理过期时间,通过逻辑标记控制更新 2. 定时任务提前更新即将过期的缓存 | 高并发且缓存重建代价高的场景(如复杂计算结果) | 后台更新增加系统负载,但分散在非高峰期 | 最终一致性(更新过程中可能不一致) |

| 缓存雪崩(预热不足) | 系统重启或缓存集群故障恢复后,大量请求直接访问数据库 | 数据库压力过大,恢复时间延长 | 1. 缓存预热(启动时加载热点数据) 2. 分级恢复(按优先级加载缓存) | 1. 启动脚本批量加载热点数据到缓存 2. 按业务重要性分批次恢复缓存 | 系统重启频繁或缓存集群易故障的场景 | 预热过程可能占用启动时间(如30-60秒) | 最终一致性(预热过程中可能不一致) |

| 缓存击穿(并发重建) | 多个请求同时发现缓存失效,并发重建缓存 | 资源浪费,可能导致数据库瞬时压力过大 | 1. 单线程重建(分布式锁) 2. 提前刷新(在缓存过期前主动更新) | 1. 使用redis的setnx命令实现互斥锁 2. 定时任务在缓存过期前50%时间点更新 | 热点数据更新频率较低的场景 | 加锁操作增加约1-3ms延迟 | 强一致性(锁持有期间) |

| 缓存穿透(恶意攻击) | 攻击者故意请求不存在的key,耗尽数据库资源 | 数据库服务不可用,业务中断 | 1. 布隆过滤器+限流 2. ip黑名单+waf防护 | 1. 布隆过滤器拦截无效请求 2. 对单个ip请求频率超过阈值(如1000次/秒)进行限流 | 开放api接口或易受攻击的场景 | 限流可能导致部分合法请求被拒绝 | n/a |

| 缓存与数据库双写不一致 | 同时更新缓存和数据库时,因网络等原因导致两者不一致 | 数据展示异常,业务计算结果错误 | 1. 先更新数据库,再删除缓存(cache-aside模式) 2. 重试机制(消息队列) | 1. 更新数据库后删除缓存,失败时记录日志并通过消息队列重试 2. 设置最大重试次数(如3次) | 对数据一致性要求较高的场景(如订单、支付) | 重试机制增加系统复杂度和延迟(约10-50ms) | 最终一致性(重试成功后) |

1. 缓存穿透(查询穿透到db)

问题:大量请求查询不存在的key,击穿缓存直达数据库。

解决方案:

- 空值缓存:对不存在的key也写入缓存(如setex key 60 "")。

- 布隆过滤器(bloom filter):提前过滤无效key(需引入redis模块或外部组件)。

2. 缓存雪崩(大量key同时过期)

问题:大量缓存同时失效,导致db压力骤增。

解决方案:

- 随机ttl:给key设置基础时间+随机偏移量(如3600+random(600))。

- 热点数据永不过期:手动维护缓存更新,避免自动过期。

- 多级缓存:本地缓存(如memcached)+ redis缓存,分担压力。

3. 缓存击穿(热点key过期)

问题:单key失效时,大量请求同时查询db。

解决方案:

- 分布式锁:如前文cache_with_lock函数,确保同一时间仅一个请求查询db。

- 互斥更新:使用lua脚本保证更新操作原子性。

4. 缓存与数据库一致性

双写策略:

先更新db,再更新缓存:并发场景可能导致缓存与db不一致。

先更新db,再删除缓存:更安全的方式,但需处理删除失败(可结合消息队列重试)。

延时双删:

def update_data_and_cache(db_key, new_data):

# 1. 更新数据库

update_db(db_key, new_data)

# 2. 删除缓存

redis_client.delete(f"cache:{db_key}")

# 3. 延时一段时间后再次删除缓存(解决主从复制延迟问题)

time.sleep(0.5)

redis_client.delete(f"cache:{db_key}")

5.解决方案选择建议

优先预防:通过合理的ttl设置(随机化+热点数据永不过期)预防雪崩和击穿

防御穿透:高并发场景必须部署布隆过滤器+空值缓存

保证一致性:关键业务采用"先更新数据库,再删除缓存+重试机制"

性能优先:对一致性要求不高的场景(如浏览量统计)使用异步写入

监控预警:实时监控缓存命中率(目标>90%)、redis内存使用率(阈值80%)、数据库qps波动

四、缓存架构与性能优化

1. 架构设计优化

单节点模式:适用于测试环境,简单但无高可用。

哨兵模式(sentinel):

sentinel monitor mymaster 127.0.0.1 6379 2 sentinel down-after-milliseconds mymaster 5000

集群模式(cluster):分片存储,支持横向扩展(推荐生产环境)。

2. 性能优化

批量操作:使用mget、pipeline减少网络往返:

# 批量获取

keys = ["user:1", "user:2", "user:3"]

results = redis_client.mget(keys)

# 管道批量操作

with redis_client.pipeline() as pipe:

for key in keys:

pipe.get(key)

results = pipe.execute()

压缩存储:对大文本数据使用lz4等算法压缩后存入redis。

热点数据预热:启动时主动加载高频访问数据到缓存。

五、redis缓存应用注意事项

缓存命中率监控:通过info cache查看keyspace_hits和keyspace_misses计算 命中率(目标>90%)。

内存淘汰策略:根据业务选择volatile-lru(淘汰带过期时间的lru数据)或allkeys-lfu(淘汰低频访问数据)。

冷热数据分离:将高频访问数据存储在独立redis实例。

缓存降级:当redis故障时,直接访问db并返回基础数据,避免服务雪崩。

数据类型选择:

- 简单字符串:使用string(如用户id->信息)。

- 结构化数据:使用hash(如user:1包含name、age字段)。

- 列表数据:使用list(如最新评论列表)。

六、实战案例:用户信息缓存

import redis

import json

class usercache:

def __init__(self, host='localhost', port=6379, db=0):

self.redis_client = redis.redis(host, port, db)

self.cache_prefix = "user:"

self.default_ttl = 3600 # 1小时

def get_user(self, user_id):

"""获取用户信息(先查缓存,再查db)"""

cache_key = f"{self.cache_prefix}{user_id}"

user_data = self.redis_client.get(cache_key)

if user_data:

return json.loads(user_data)

# 缓存未命中,查询db(实际项目中替换为真实db查询)

user_data = self._query_db(user_id)

if user_data:

self.redis_client.setex(

cache_key,

self.default_ttl,

json.dumps(user_data)

)

return user_data

def update_user(self, user_id, user_data):

"""更新用户信息(先更新db,再删除缓存)"""

# 1. 更新db

self._update_db(user_id, user_data)

# 2. 删除缓存(避免脏数据)

cache_key = f"{self.cache_prefix}{user_id}"

self.redis_client.delete(cache_key)

def _query_db(self, user_id):

"""模拟数据库查询"""

return {"id": user_id, "name": f"user_{user_id}", "create_time": time.time()}

def _update_db(self, user_id, user_data):

"""模拟数据库更新"""

print(f"updating user {user_id} in database...")

通过以上方案,可在redis中实现高效、稳定的缓存功能。实际应用中需根据业务场景调整策略,同时结合监控系统(如prometheus+grafana)实时追踪缓存性能与健康状态。

到此这篇关于一文浅析如何在redis中实现缓存功能的文章就介绍到这了,更多相关redis缓存内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论