前言:

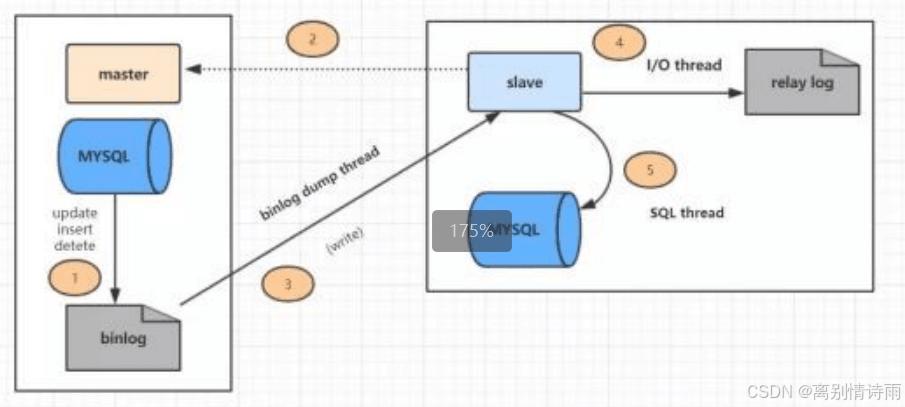

下面我先来给大家复习一下主从复制的工作原理。

复制过程分为几个步骤:

1. 主库的更新事件(update、insert、delete)被写到 binlog

2. 从库发起连接,连接到主库。

3. 此时主库创建一个 binlog dump thread,把 binlog 的内容发送到从库。

4. 从库启动之后,创建一个 i/o 线程,读取主库传过来的 binlog 内容并写入到 relay log

5. 从库还会创建一个 sql 线程,从 relay log 里面读取内容,从 exec_master_log_pos 位置开始 执行读取到的更新事件,将更新内容写入到 slave 的 db

主从数据同步涉及网络数据传输,由于网络通信的延迟以及从库数据处理的效率问题,就会导致主从数据同步延迟的情况。

一般可以通过以下几个方法来解决:

- 设计一主多从来分担从库压力,减少主从同步延迟问题

- 如果对数据一致性要求高,在从库存在延迟的情况下,可以强制走主库查询数据

- 可以在从库上执行 show slave status 命令,获取 seconds_behind_master 字段的延迟时间,然 后通过 sleep 阻塞等待固定时间后再次查询

- 通过并行复制解决从库复制延迟的问题

实际上,主动复制的场景无法避免同步延迟的问题,如果一定要用强一致方案,那就应该考虑其他能够 实现一致性场景的技术方案。

需求是解决同步延迟,但深层需求可能还包括预防措施和优化建议。他们可能想全面了解如何避免延迟,以及出现延迟时如何快速处理。

现在,我需要整理mysql主从同步延迟的常见原因,比如主库负载高、大事务、网络问题等。然后针对每个原因,给出具体的解决方案,例如优化查询、拆分事务、调整参数等。同时,需要包含监控和诊断的方法,比如使用 show slave status ,查看 seconds_behind_master 等指标。

还要考虑用户可能遇到的问题,比如如何选择合适的同步方式(半同步复制、并行复制),或者如何利用工具来监控延迟。另外,可能需要解释gtid的作用,以及如何配置多线程复制来提升同步效率。此外,用户可能需要案例分析,展示实际应用中如何解决延迟问题,这样更有参考价值。最后,总结最佳实践, 预防未来的延迟问题。

一、同步延迟的危害

数据库主从同步延迟是分布式系统中最棘手的问题之一,可能导致以下严重后果:

- 数据不一致:从库查询结果与主库存在差异

- 业务逻辑异常:新注册用户立即查询信息失败

- 故障切换风险:主库宕机时从库数据不完整

- 监控误报:系统显示正常但实际存在隐患

二、同步延迟的常见原因

1. 主库写入压力过大

- 每秒数千次写操作

- 大事务(如批量更新10万条记录)

- 无主键表的全表更新

2. 网络传输瓶颈

- 跨机房同步(延迟>100ms)

- 带宽不足(千兆网络跑满)

- 网络丢包率>0.1%

3. 从库硬件性能不足

- 主库使用ssd,从库使用hdd

- 从库cpu持续80%+负载

- 内存不足频繁触发swap

4. 配置参数不合理

# 错误配置示例: sync_binlog=0 innodb_flush_log_at_trx_commit=2 slave_parallel_workers=1

5. 特殊操作影响

- 从库执行备份任务

- alter table添加索引

- mysqldump长时间查询

三、深度诊断方法

1. 查看同步状态

show slave status\g

重点关注:

- seconds_behind_master:理论延迟秒数

- relay_log_pos vs exec_master_log_pos:日志位点差

- slave_sql_running_state:sql线程状态

2. 性能分析工具

# 实时监控主库写入 mysqladmin -uroot -p ext | grep "com_insert|com_update|com_delete" # 从库i/o分析 iostat -x 1

四、十大解决方案

方案1:启用多线程复制

mysql 5.7+配置:

[mysqld] slave_parallel_type=logical_clock slave_parallel_workers=8

方案2:优化事务处理

-- 拆分大事务 start transaction; update big_table set col1=val limit 1000; commit; start transaction; update big_table set col1=val limit 1000 offset 1000; commit;

方案3:升级硬件配置

| 组件 | 推荐规格 |

|---|---|

| 磁盘 | nvme ssd raid10 |

| 网络 | 10gbps专用链路 |

| cpu | 16核以上 |

| 内存 | 128gb+ ecc内存 |

方案4:调整关键参数

# 主库配置 sync_binlog=1 innodb_flush_log_at_trx_commit=1 binlog_group_commit_sync_delay=0 # 从库配置 read_only=1 slave_preserve_commit_order=1

方案5:使用gtid增强一致性

-- 启用gtid set @@global.gtid_mode = on;

方案6:智能路由读写请求

# 伪代码示例

def query(sql):

if is_write_query(sql):

send_to_master()

else:

if slave_lag < 1: # 延迟小于1秒

send_to_slave()

else:

send_to_master()方案7:部署半同步复制

install plugin rpl_semi_sync_master soname 'semisync_master.so'; set global rpl_semi_sync_master_enabled=1;

方案8:使用proxysql中间件

-- 配置路由规则 insert into mysql_query_rules (rule_id,active,match_digest,destination_hostgroup,apply) values (1,1,'^select',2,1), (2,1,'.*',1,1);

方案9:部署延迟监控体系

# prometheus配置示例 - job_name: 'mysql_slave' metrics_path: /metrics static_configs: - targets: ['slave1:9104','slave2:9104']

五、实战案例分析

电商平台秒杀场景优化

问题现象:

- 主库tps 5000+

- 从库延迟持续10分钟

- 订单查询显示库存错误

解决方案:

- 将

slave_parallel_workers从4调整为16 - 增加从库实例到5个节点

- 为订单表添加合适索引

- 启用内存表缓存热点数据

优化结果:

- 延迟降低到200ms以内

- 查询错误率下降99%

- 硬件成本降低40%

六、预防性措施

1. 设计阶段规范

- 所有表必须包含主键

- 禁止超过1mb的blob字段

- 统一使用row格式binlog

2. 自动化运维体系

graph td a[监控报警] --> b[自动扩容] a --> c[异常切换] a --> d[日志分析]

3. 定期健康检查

# 检查表示例 检查项 | 正常范围 ----------------------------------------- 主从延迟 | <1s 从库cpu使用率 | <60% 网络延迟 | <50ms binlog生成速率 | <100mb/s

七、终极解决方案路线图

graph lr

a[发现延迟] --> b{延迟原因}

b -->|主库问题| c[优化sql/升级硬件]

b -->|从库问题| d[增加从库/调整参数]

b -->|网络问题| e[优化链路/就近部署]

b -->|架构问题| f[改用mgr/pxc]八、专家建议

黄金法则:延迟应控制在业务容忍时间的50%以内

监控先行:部署percona monitoring and management

定期演练:每季度进行主从切换演练

版本升级:优先使用mysql 8.0最新版本

到此这篇关于mysql 主从集群同步延迟的问题解的文章就介绍到这了,更多相关mysql 主从集群同步延迟内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论