问题背景

假设你拥有一个包含大量联系人信息的 csv 文件,需要将这些信息迁移到数据库中。这些联系人信息可能包含姓名、电话号码、邮箱地址等。如果使用传统的单线程方式,逐条处理数据,迁移过程可能会非常缓慢,尤其是在数据量很大时。

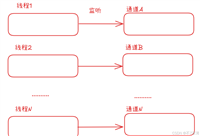

在处理大量的 csv 文件数据并迁移到数据库时,使用并发可以显著提升处理效率。go 语言的 goroutine 和通道(channel)非常适合用来并发地处理数据。

下面我将给出一个示例,展示如何使用 go 语言并发地处理 csv 文件,并将数据插入到数据库中。

主要思路

读取 csv 文件:使用 encoding/csv 包来解析 csv 文件。

并发处理数据:将 csv 文件的数据分批次发送到多个 goroutine 中进行并发处理。

数据库插入:每个 goroutine 从通道中接收数据并将其插入到数据库中。

同步控制:使用 sync.waitgroup 来等待所有 goroutine 完成任务。

假设我们的数据库是 mysql,使用 github.com/jinzhu/gorm 作为 orm 库来处理数据库插入。我们会定义一个 contact 结构体来映射数据库中的表,并用并发

的方式将每一行 csv 数据插入到数据库。

示例代码

1. 安装必要的依赖

首先,你需要安装 gorm 和 csv 相关的包:

go get github.com/jinzhu/gorm go get github.com/jinzhu/gorm/dialects/mysql go get encoding/csv

2. 数据库模型定义

我们先定义一个 contact 结构体,它会对应数据库中的联系人表。

package main

import (

"github.com/jinzhu/gorm"

_ "github.com/jinzhu/gorm/dialects/mysql"

"fmt"

)

// contact 是数据库中表的模型

type contact struct {

id uint `gorm:"primary_key"`

name string `gorm:"size:255"`

phone string `gorm:"size:255"`

email string `gorm:"size:255"`

}

func initdb() (*gorm.db, error) {

// 使用 mysql 数据库

db, err := gorm.open("mysql", "user:password@/dbname?charset=utf8&parsetime=true&loc=local")

if err != nil {

return nil, err

}

// 自动迁移表结构

db.automigrate(&contact{})

return db, nil

}

3. 读取 csv 文件并处理

接下来,我们需要读取 csv 文件并将每一行数据并发地插入到数据库中。

package main

import (

"encoding/csv"

"fmt"

"os"

"strings"

"sync"

)

// 处理 csv 文件并将数据插入数据库

func processcsv(filepath string, db *gorm.db) error {

// 打开 csv 文件

file, err := os.open(filepath)

if err != nil {

return err

}

defer file.close()

// 创建 csv 阅读器

reader := csv.newreader(file)

// 读取所有行

records, err := reader.readall()

if err != nil {

return err

}

// 使用 waitgroup 来同步所有的 goroutine

var wg sync.waitgroup

// 通道用于发送每行数据

ch := make(chan contact, len(records))

// 启动多个 goroutine 来并发处理 csv 数据

for i := 1; i < len(records); i++ { // 从 1 开始,跳过标题行

wg.add(1)

go func(record []string) {

defer wg.done()

// 将 csv 行转换为 contact 实例

contact := contact{

name: record[0],

phone: record[1],

email: record[2],

}

ch <- contact // 发送数据到通道

}(records[i])

}

// 启动一个 goroutine 来将通道中的数据插入到数据库

go func() {

for contact := range ch {

if err := db.create(&contact).error; err != nil {

fmt.println("error inserting record:", err)

}

}

}()

// 等待所有 goroutine 完成

wg.wait()

// 关闭通道

close(ch)

return nil

}

func main() {

// 初始化数据库

db, err := initdb()

if err != nil {

fmt.println("failed to connect to database:", err)

return

}

defer db.close()

// 处理 csv 文件并将数据迁移到数据库

err = processcsv("contacts.csv", db)

if err != nil {

fmt.println("error processing csv file:", err)

return

}

fmt.println("csv data successfully migrated to the database.")

}

代码说明

初始化数据库:

- initdb 函数用于初始化 mysql 数据库连接并进行自动迁移。

- 我们使用 gorm 来处理数据库操作,模型 contact 映射到数据库中的 contacts 表。

读取 csv 文件:

- processcsv 函数打开并读取 csv 文件。然后,它读取所有的记录,并将每条记录通过 goroutine 异步发送到通道中。

- 每个 goroutine 都会将一条记录从 csv 转换为 contact 对象,并将其发送到通道。

并发处理数据:

- sync.waitgroup 被用来确保所有的 goroutine 完成任务。wg.add(1) 在启动每个 goroutine 时调用,wg.done() 在每个 goroutine 完成时调用。

- 使用 chan contact 通道来将数据从多个 goroutine 传递到数据库插入部分。一个单独的 goroutine 从通道中接收数据并将其插入到数据库。

并发插入数据库:

每个 goroutine 向通道发送数据,然后另一个 goroutine 从通道中读取数据并将其插入数据库。通过这种方式,多个数据库插入操作是并发进行的。

关闭通道与等待:

- 在所有数据都发送到通道后,使用 wg.wait() 等待所有 goroutine 完成处理。

- 关闭通道以确保数据库插入操作可以顺利结束。

性能优化

在这个例子中,我们并发地读取 csv 文件并将数据插入数据库,显著提高了处理速度。但是,对于大型数据集,还可以做更多的性能优化:

批量插入:可以将多个数据条目批量插入数据库,而不是每次插入一条记录。批量插入可以显著减少数据库的 i/o 操作,提升性能。

控制并发数:通过 semacphore 或者限制通道缓冲区大小,可以控制并发数,避免数据库被过多并发请求压垮。

数据库连接池:确保数据库连接池的配置合理,避免过多的并发连接造成数据库连接耗尽。

总结

通过并发处理,我们能够大大提升 csv 文件迁移到数据库的速度。go 的 goroutines 和通道非常适合这种类型的任务,可以高效地处理 i/o 密集型的操作。在处理大型 csv 文件时,使用并发处理可以显著提升性能,减少总体处理时间。

到此这篇关于使用go语言实现并发处理csv文件到数据库的文章就介绍到这了,更多相关go并发处理csv内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论