deepseek 是一个开源的深度学习模型,常用于自然语言处理和推荐系统。如果你想将 deepseek 本地部署,以下是一般步骤:

环境要求

- 操作系统:linux(推荐)或 windows

- python:>= 3.7

- 依赖包:

- pytorch (>= 1.7.1)

- transformers (>= 4.0)

- 其他相关的库如 numpy, pandas, scikit-learn等

部署步骤

1. 克隆 deepseek 仓库

首先,你需要从 deepseek 的 github 仓库中克隆代码。

git clone https://github.com/your-repository/deepseek.git cd deepseek

2. 创建虚拟环境

为了避免与其他项目产生冲突,推荐使用虚拟环境。

python3 -m venv deepseek-env source deepseek-env/bin/activate # linux # 或者 windows # deepseek-env\scripts\activate

3. 安装依赖

进入项目目录后,安装 deepseek 需要的依赖库。

pip install -r requirements.txt

4. 配置模型

根据你的需求,deepseek 可能需要一些预训练的模型。你可以通过以下命令下载它们:

python download_model.py # 下载预训练模型

5. 配置数据

将你的数据准备好,并根据 config.json 文件配置数据路径。通常,deepseek 需要输入的数据格式为文本数据或其他适合的格式。

6. 启动服务

如果 deepseek 提供了一个 api 服务器,你可以使用以下命令启动它:

python run_server.py

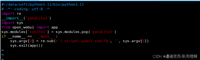

或者你可以直接在 python 脚本中调用模型进行推理:

from deepseek import deepseekmodel model = deepseekmodel() result = model.predict(input_data) print(result)

7. 调试与优化

你可以根据项目需求进行调试和优化。如果 deepseek 进行 gpu 加速,确保已安装 nvidia 驱动并正确配置 pytorch 支持 cuda。

8. 使用接口进行调用(可选)

如果 deepseek 提供了 api,你可以通过 http 请求调用接口,或直接通过模型类调用。示例如下:

import requests url = 'http://localhost:5000/predict' data = {'input': '你的输入数据'} response = requests.post(url, json=data) print(response.json()) # 获取预测结果常见问题

- 依赖问题:确保所有依赖库都正确安装,可以尝试升级

pip或使用--no-cache-dir重新安装。 - 模型下载问题:如果下载模型失败,检查网络连接,或者尝试手动下载模型并指定路径。

- gpu 加速问题:如果使用 gpu,请确保你的机器上安装了正确版本的 cuda 和 cudnn。

到此这篇关于deepseek本地部署使用教程的文章就介绍到这了,更多相关deepseek部署使用内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论