一、安装llama模型文件

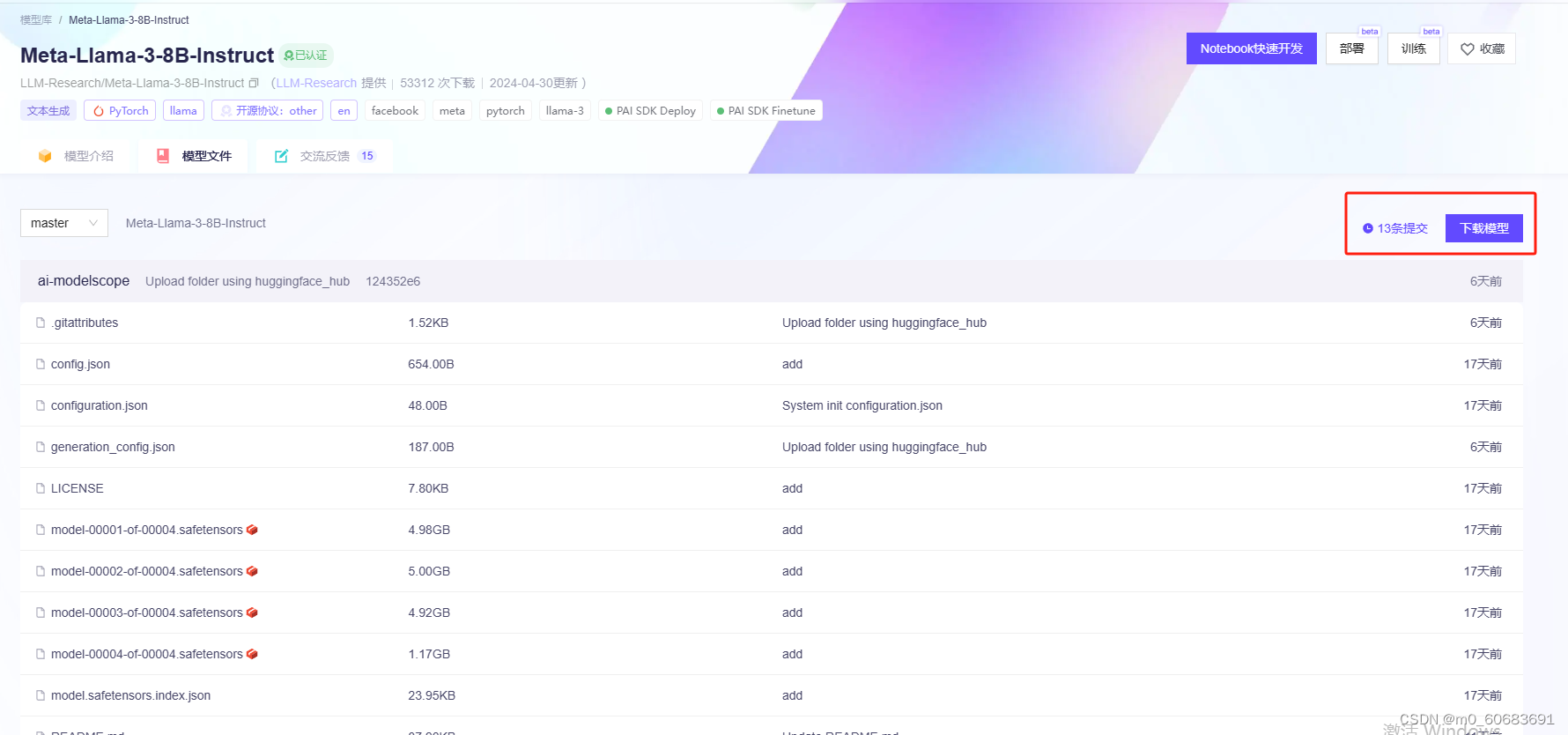

下载地址(魔塔):https://modelscope.cn/models/llm-research/meta-llama-3-8b-instruct/files

点击下载模型,复制git命令:

git clone https://www.modelscope.cn/llm-research/meta-llama-3-8b-instruct.git

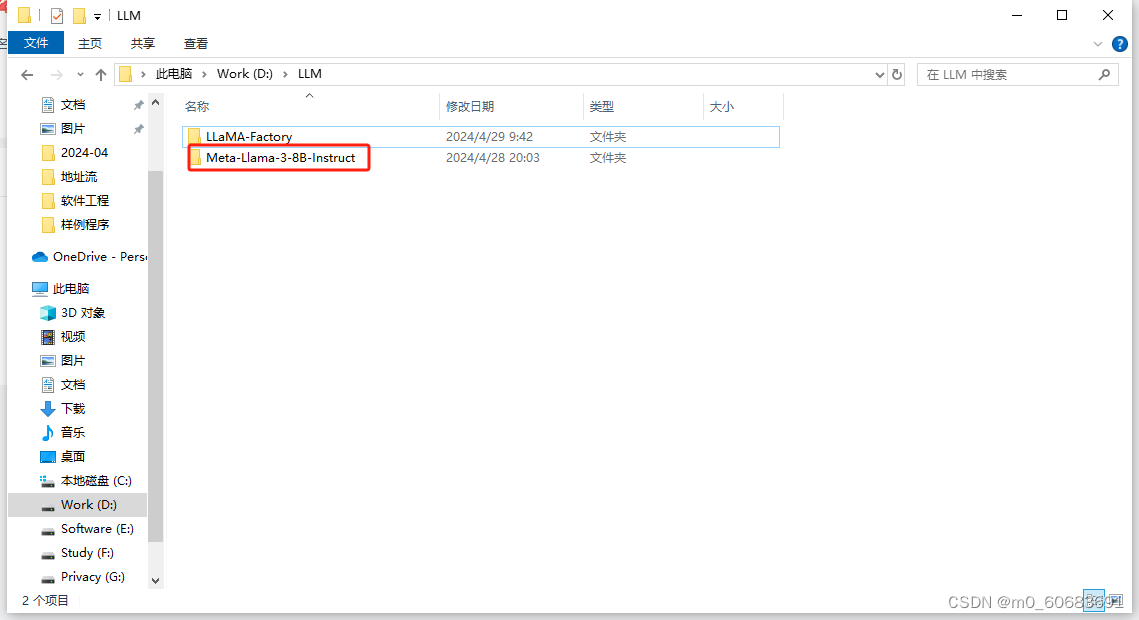

在存放模型空白处右键,点击git bash here,下载llama3模型至本地

由于文件较大,因此该过程比较久,保持下载窗口打开,知道出现下一命令行表示下载完成。

二、安装llama-factory

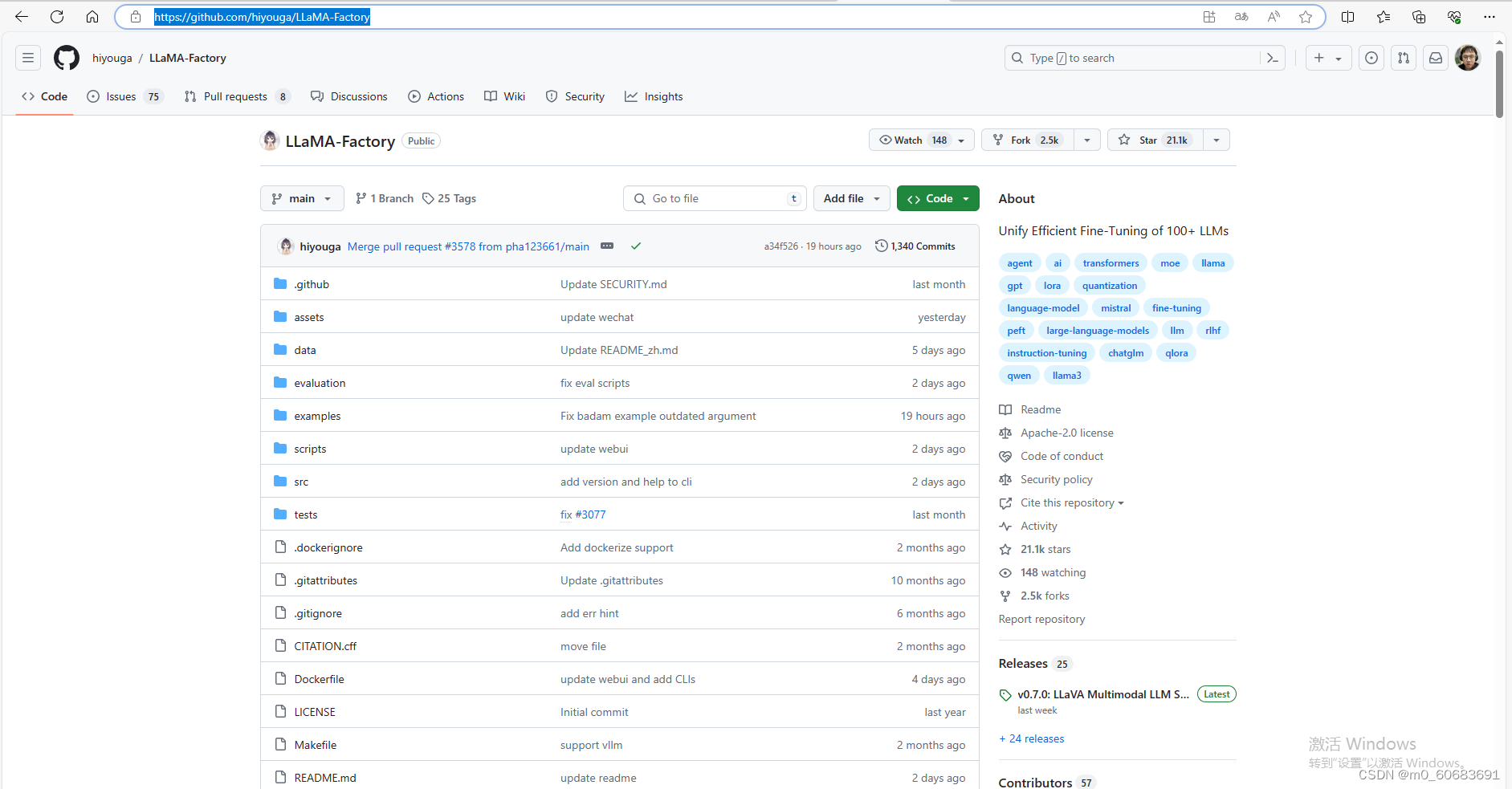

github:hiyouga/llama-factory: unify efficient fine-tuning of 100+ llms (github.com)

将其下载到本地

三、为llama-factory配置环境

进入llama-factory目录,在路径处输入cmd并回车进入该目录位置的终端

新建虚拟环境

conda create -n llama_factory python=3.10 -y激活虚拟环境

conda activate llama_factory安装依赖

pip install -e .[metrics,modelscope,qwen]pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121pip install https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl安装tensorboard

pip install tensorboard设置环境变量

set use modelscope hub=1四、运行llama-factory的webui.py

执行代码

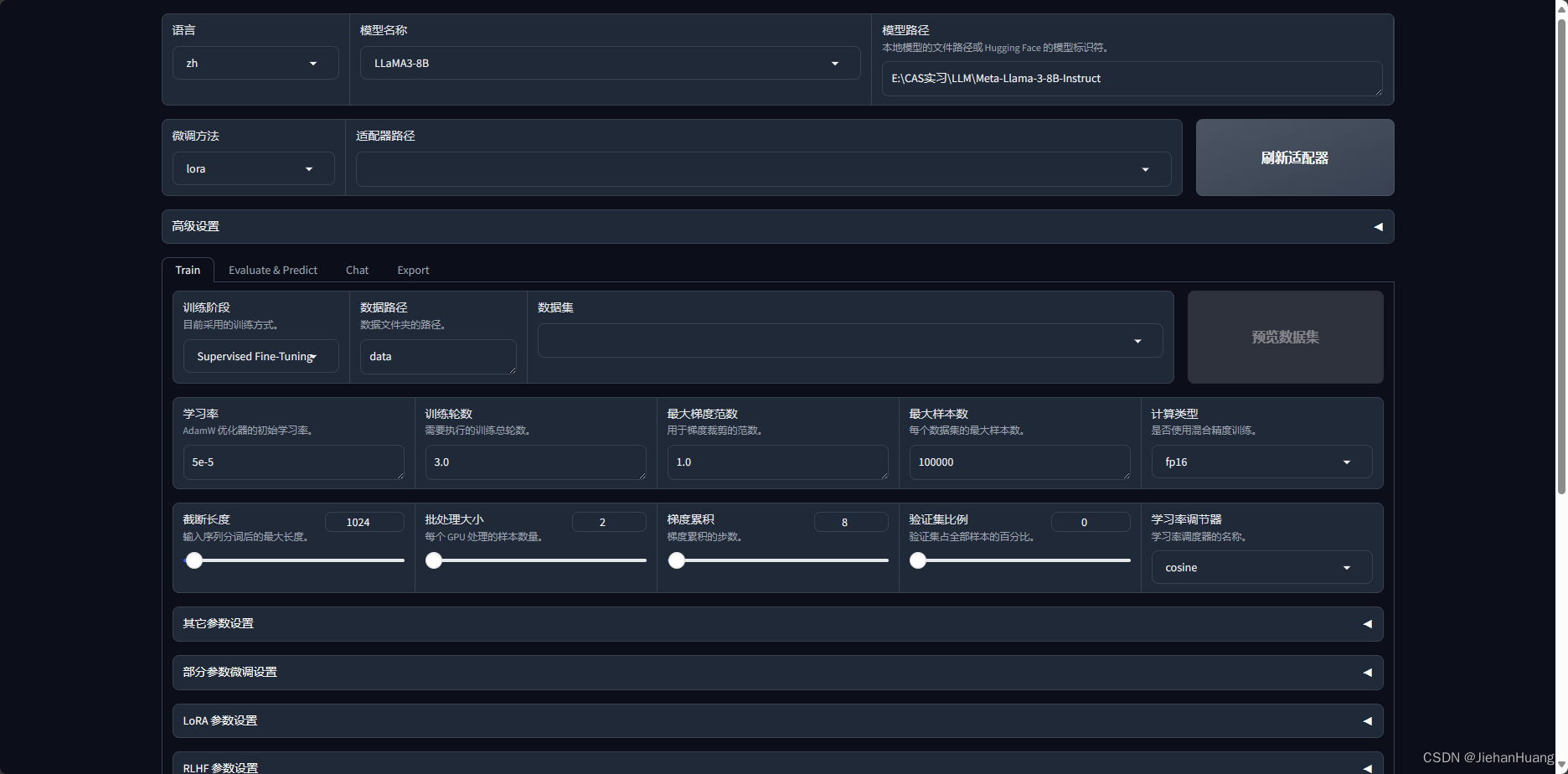

python src/webui.py若顺利,会打开如下网页(初始界面)

五、微调模型

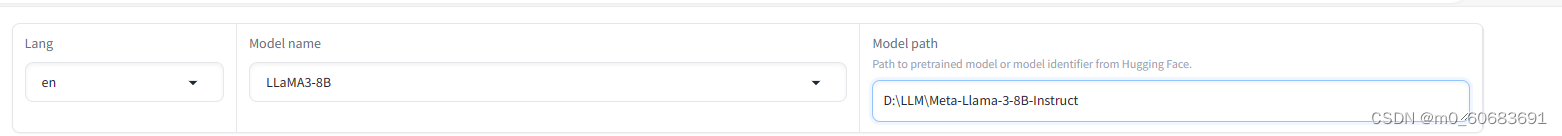

在“model name”中选择“llama3-8b”,将“model path”中的路径填写meta-llama-3-8b-instruct文件夹的路径

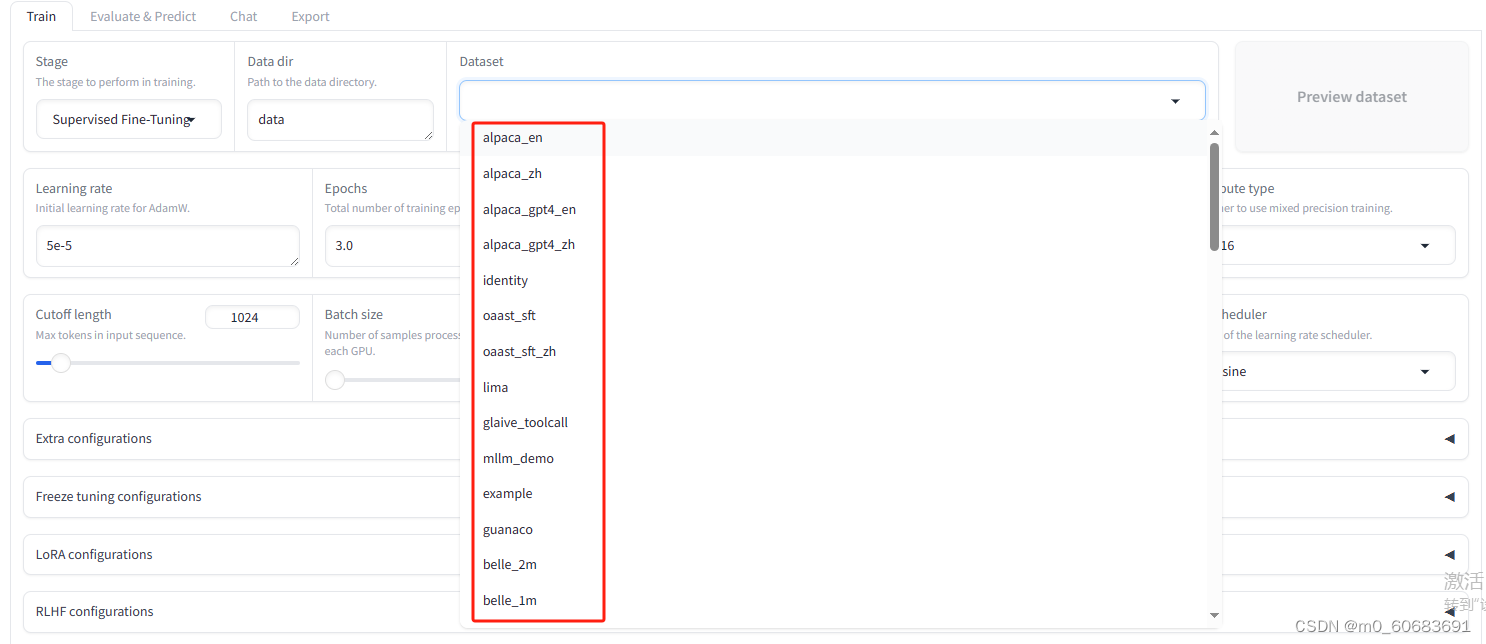

在dataset中即可选择预先准备好的数据集进行微调

以微调为中文模型举例,则在下拉选项中选择后缀为zh的数据集

点击“start”开始微调。

六、导出模型

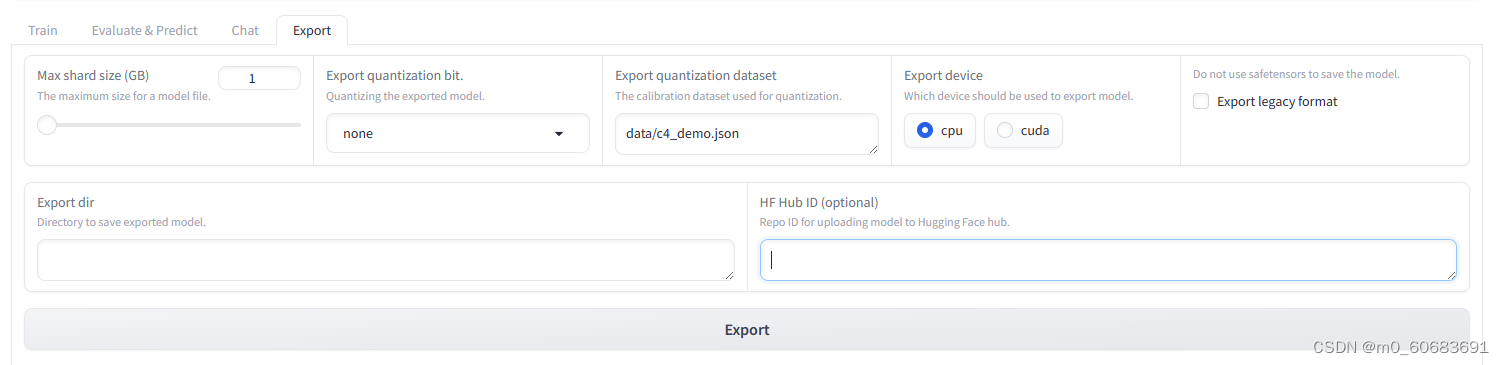

1.微调训练结束之后,点击“export”选项卡,切换到导出功能区!

2.点击“refresh adapters”按钮,刷新lora模型,在左侧的下拉列表中选择刚刚训练好的模型!

3.在“max shard size(gb)”中设置好每个拆分模型的最大size;

4.在“export dir”中设置模型保存的路径;

5.点击“export”按钮,开始导出模型(需要点时间等待);

发表评论