一、下载 hadoop

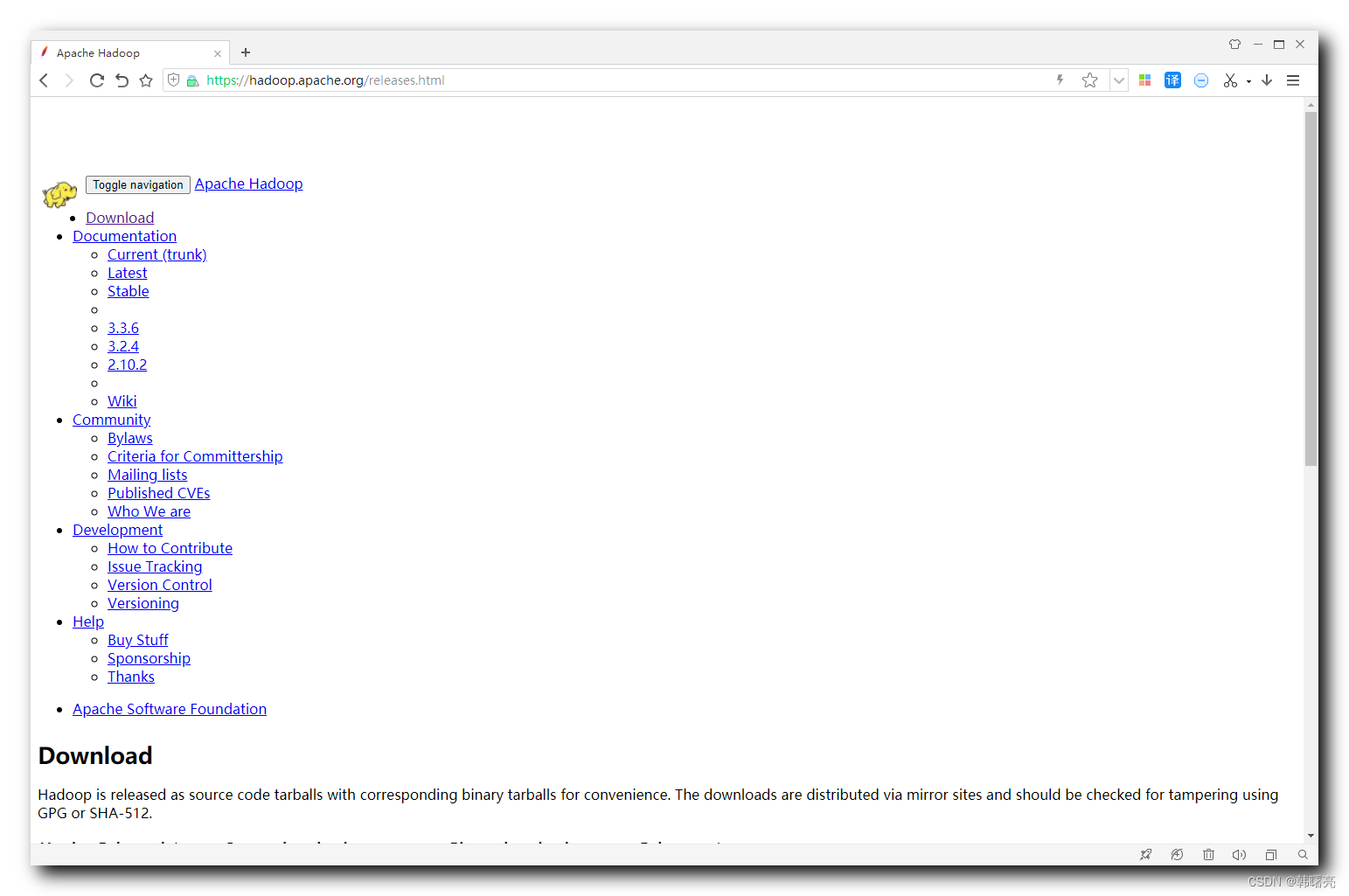

hadoop 发布版本在 https://hadoop.apache.org/releases.html 页面可下载 ;

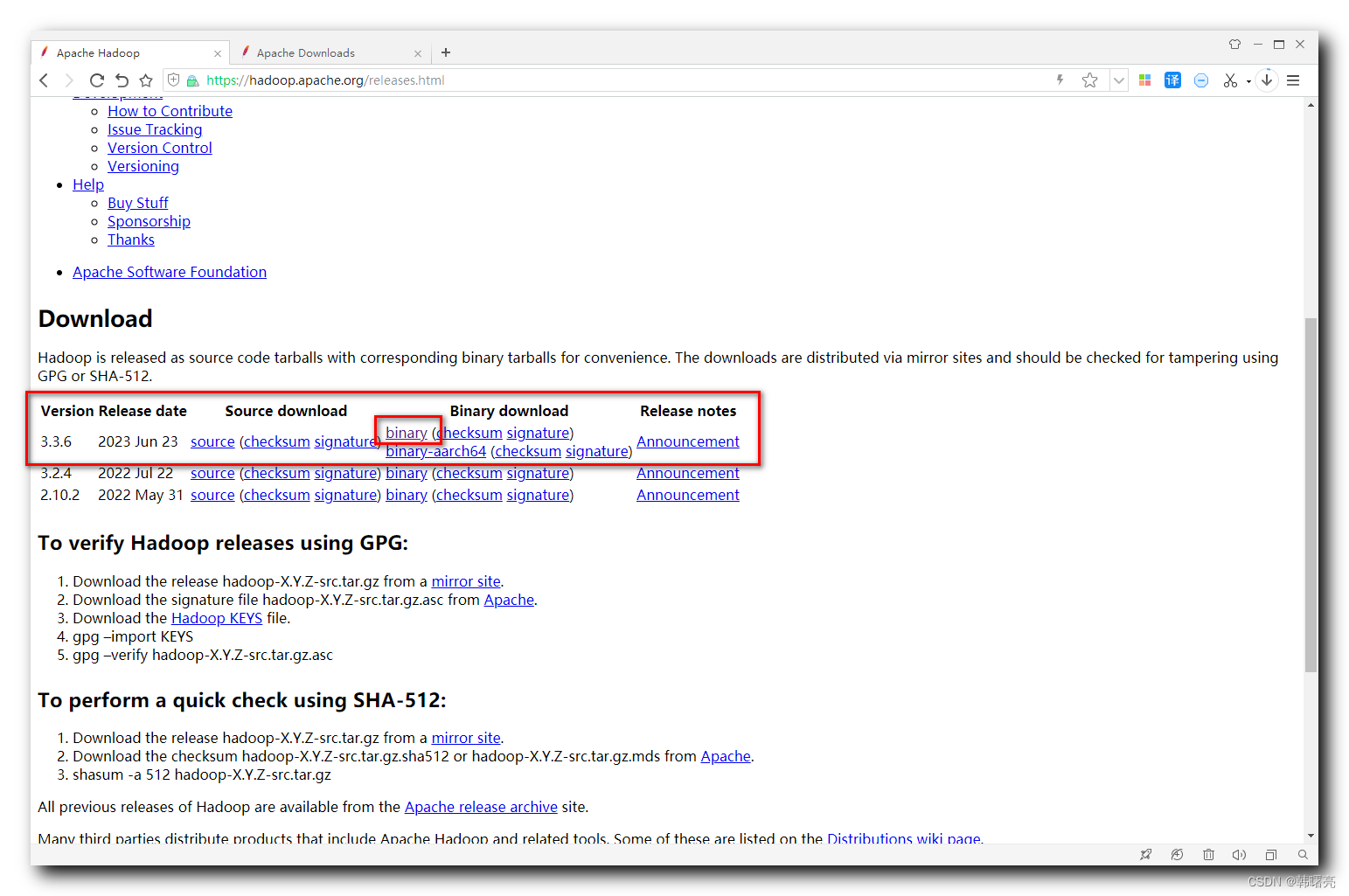

当前最新版本是 3.3.6 , 点击 binary download 下的 binary (checksum signature) 链接 ,

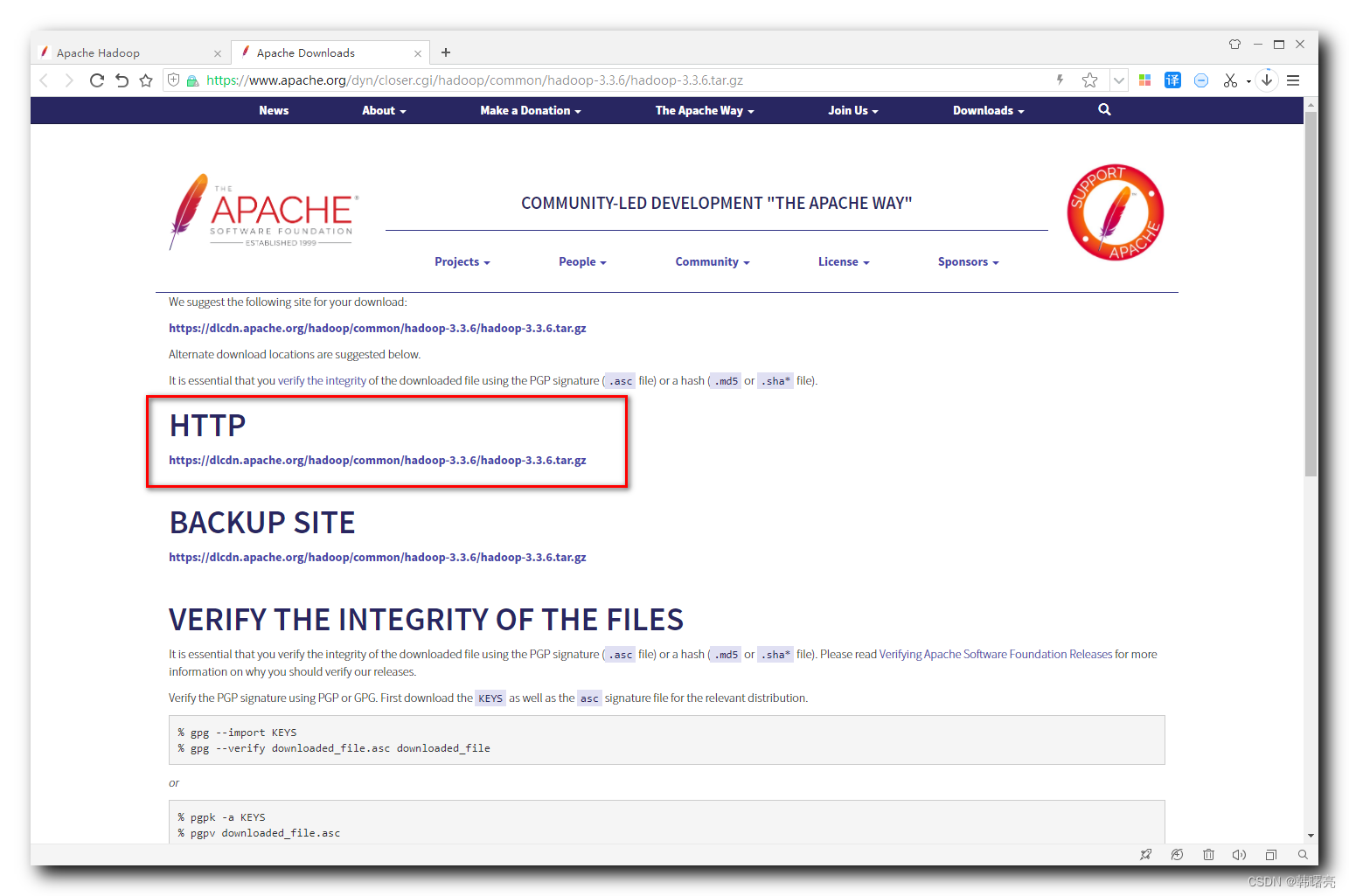

进入到 hadoop 3.3.6 下载页面 :

下载地址为 :

https://dlcdn.apache.org/hadoop/common/hadoop-3.3.6/hadoop-3.3.6.tar.gz

官方下载速度很慢 ;

这里提供一个 hadoop 版本 , hadoop 3.3.4 + winutils , csdn 0 积分下载地址 :

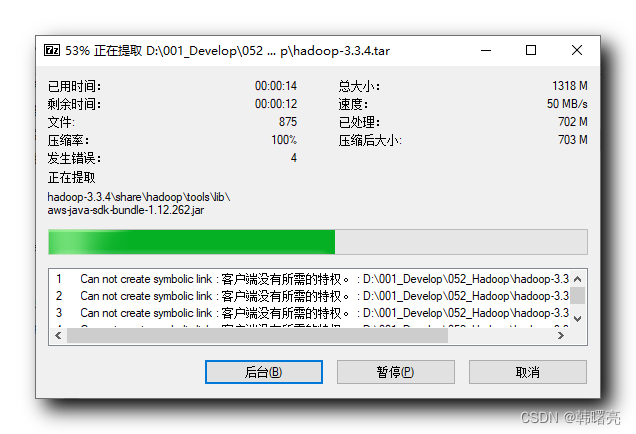

二、解压 hadoop

解压时 , 不要直接使用 解压工具 解压 , 会报错 ;

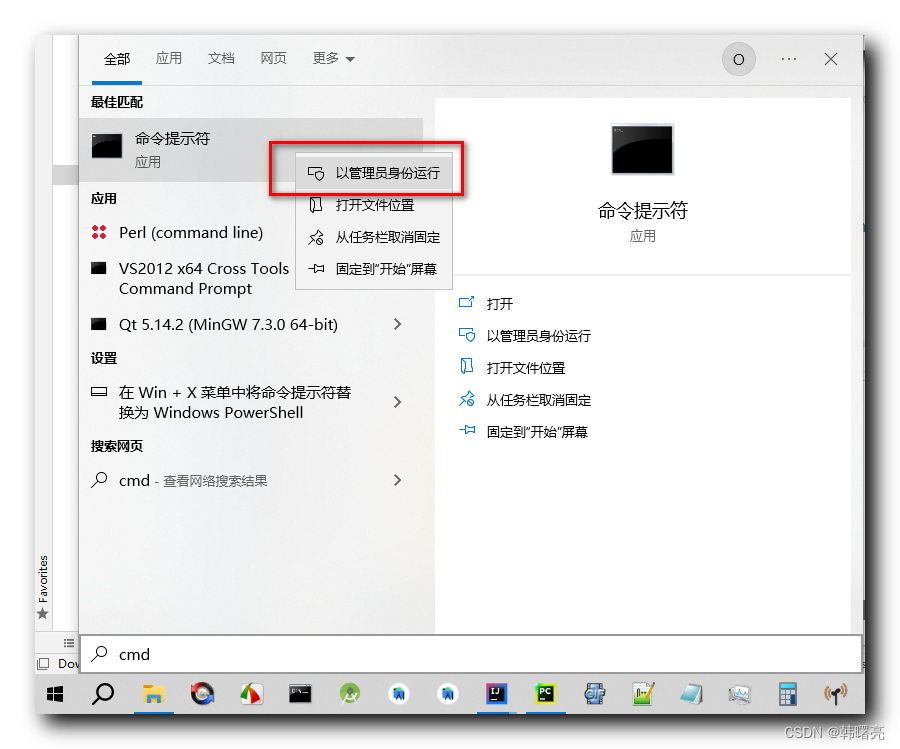

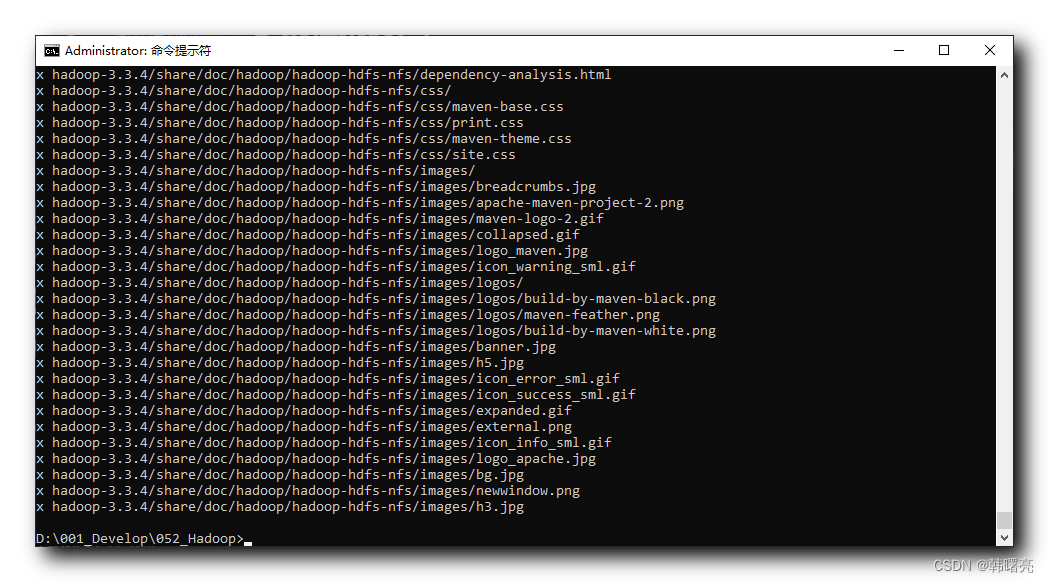

在 " 搜索 " 中 , 搜索 cmd , 然后右键点击 命令提示符 应用 ,

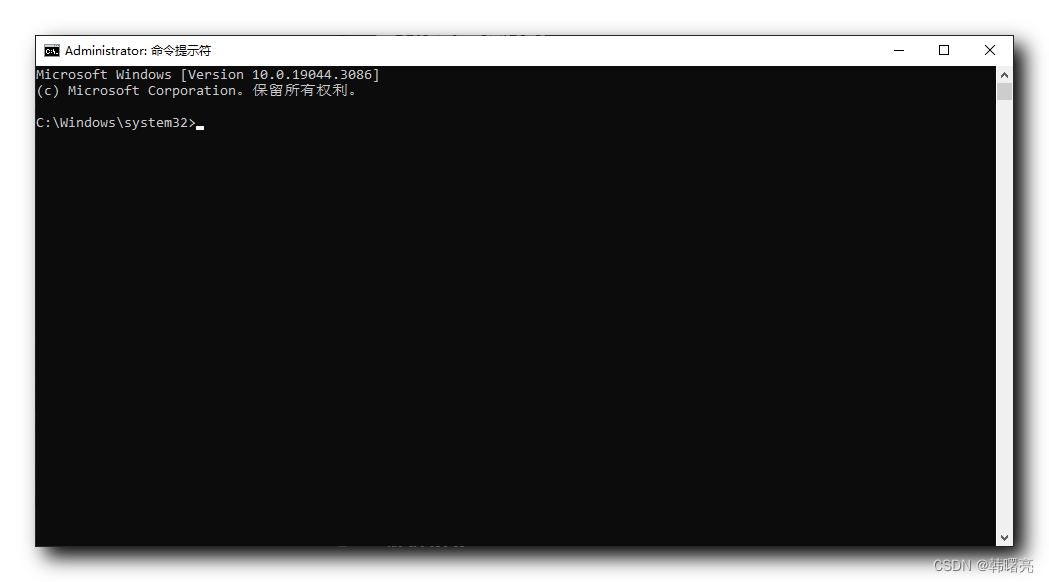

此时弹出的 命令提示符 有 管理员 权限 ;

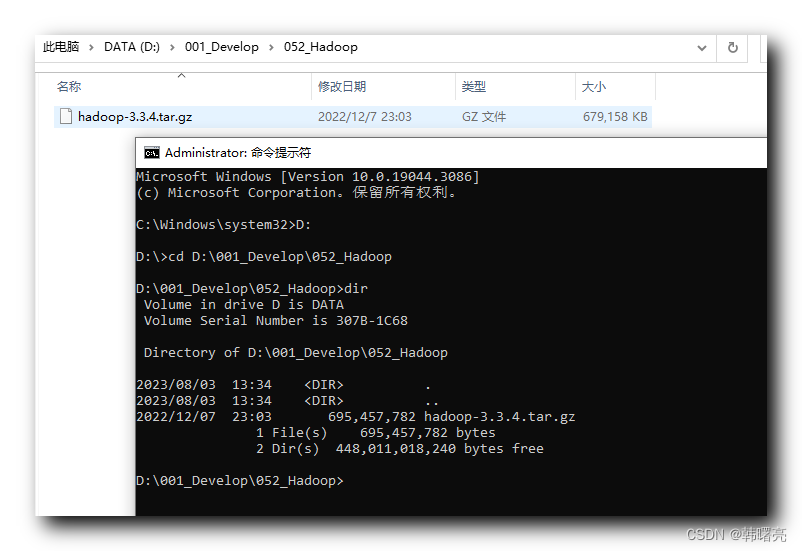

进入 hadoop 的安装目录 d:\001_develop\052_hadoop ,

执行

tar zxvf hadoop-3.3.4.tar.gz

命令 , 解压该压缩包 , 这样可以将 hadoop 完美解压出来 , 不会报错 ;

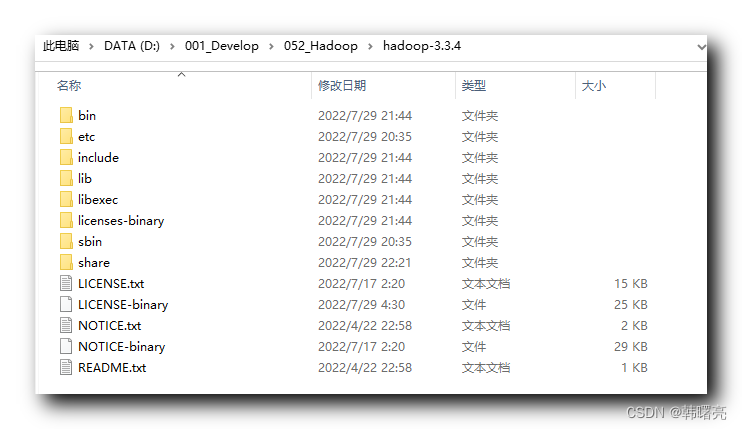

解压 hadoop 完成后 , hadoop 路径为

d:\001_develop\052_hadoop\hadoop-3.3.4

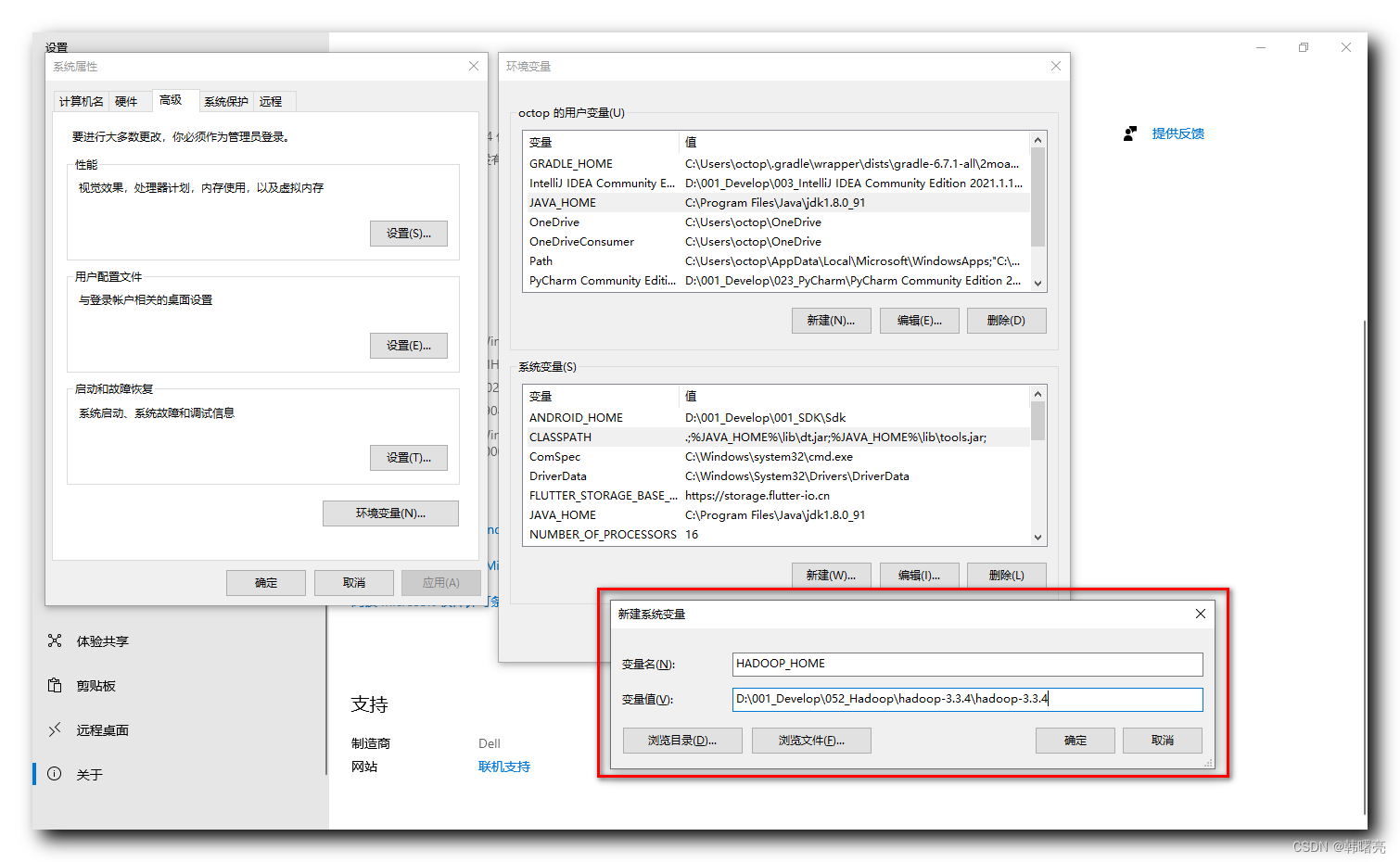

三、设置 hadoop 环境变量

在 环境变量 中 , 设置

hadoop_home = d:\001_develop\052_hadoop\hadoop-3.3.4

系统 环境变量 ;

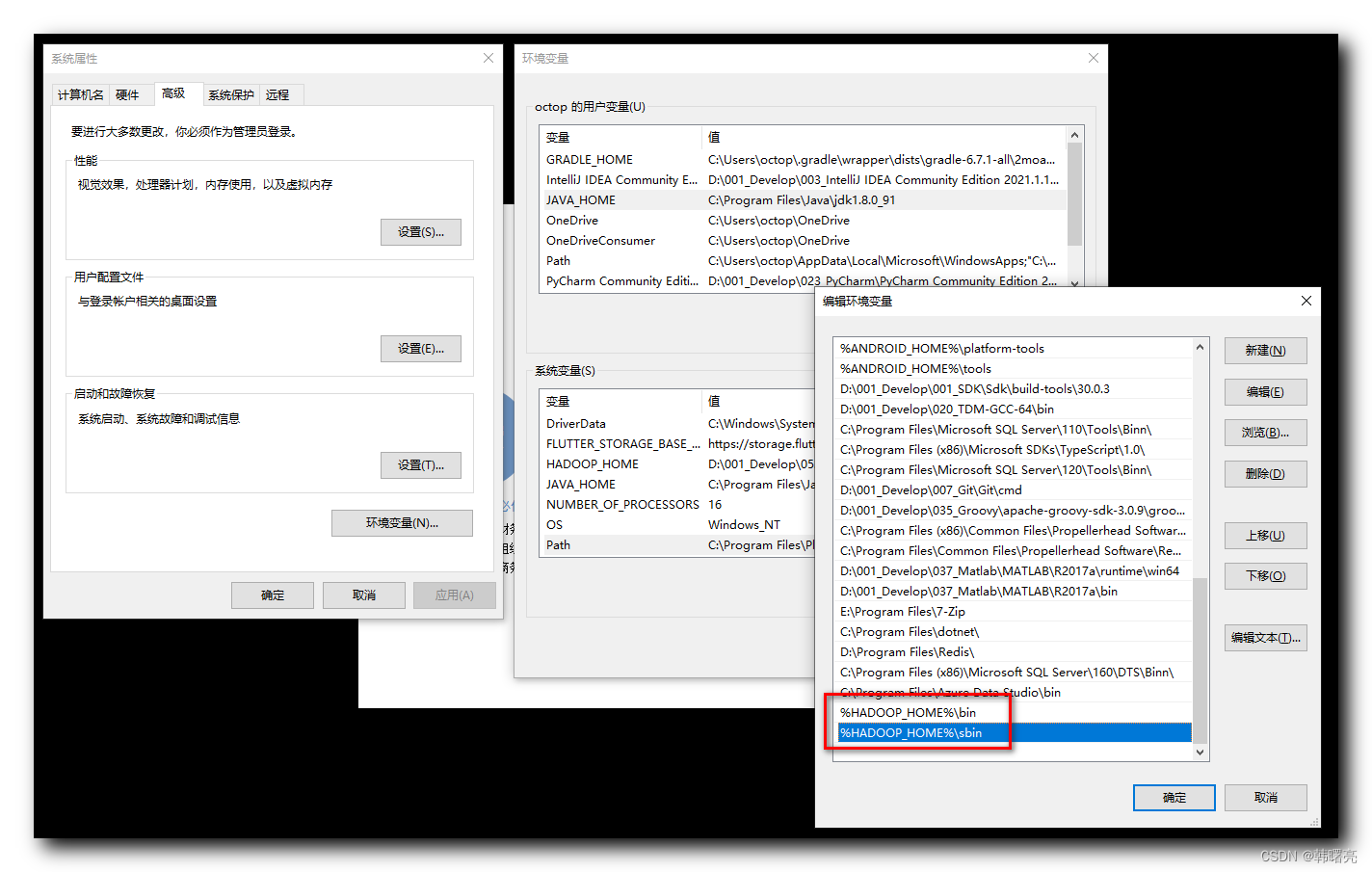

在 path 环境变量中 , 增加

%hadoop_home%\bin

%hadoop_home%\sbin

环境变量 ;

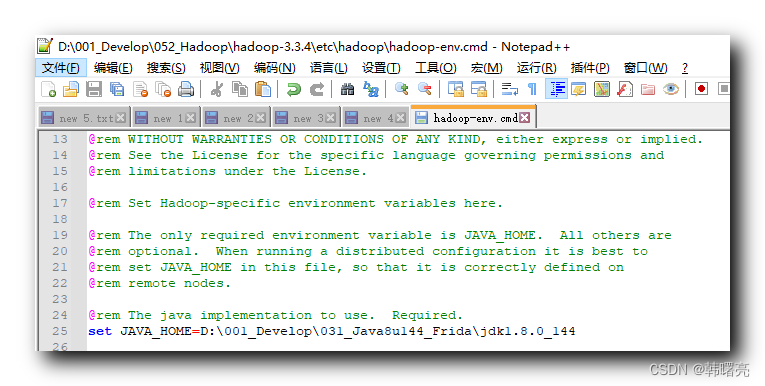

四、配置 hadoop 环境脚本

设置 d:\001_develop\052_hadoop\hadoop-3.3.4\etc\hadoop\hadoop-env.cmd 脚本中的 java_home 为真实的 jdk 路径 ;

将

set java_home=%java_home%

修改为

set java_home=d:\001_develop\031_java8u144_frida\jdk1.8.0_144

注意 : 路径中不要出现空格 , 尤其是 program files 目录 , 不要把 jdk 安装在这个目录中 , 有大坑 ;

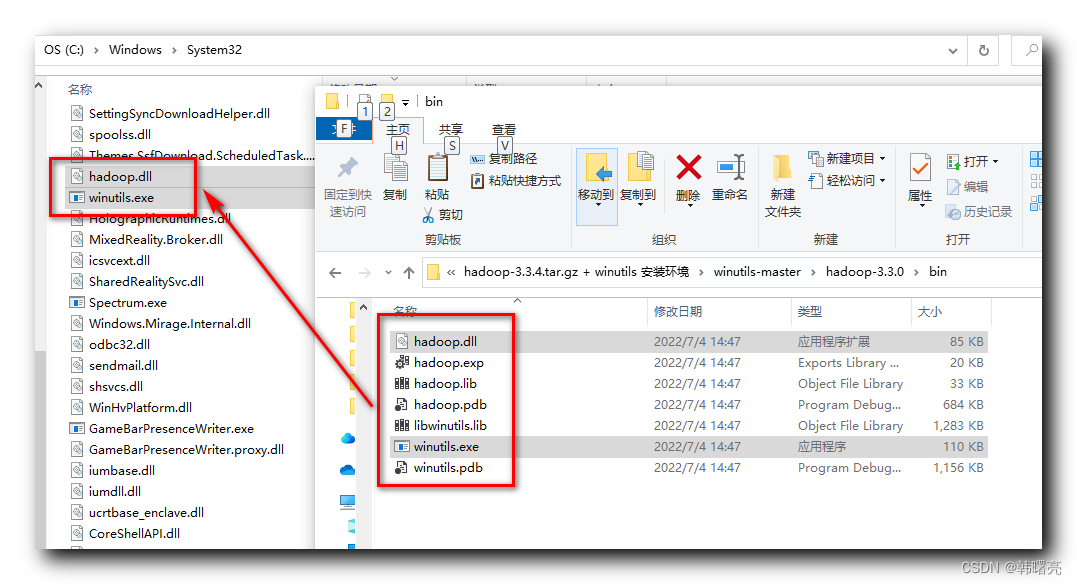

五、安装 winutils

将 winutils-master\hadoop-3.3.0\bin 中的 hadoop.dll 和 winutils.exe 文件拷贝到 c:\windows\system32 目录中 ;

六、重启电脑

重启电脑 , 一定要重启 , 否则不生效 ;

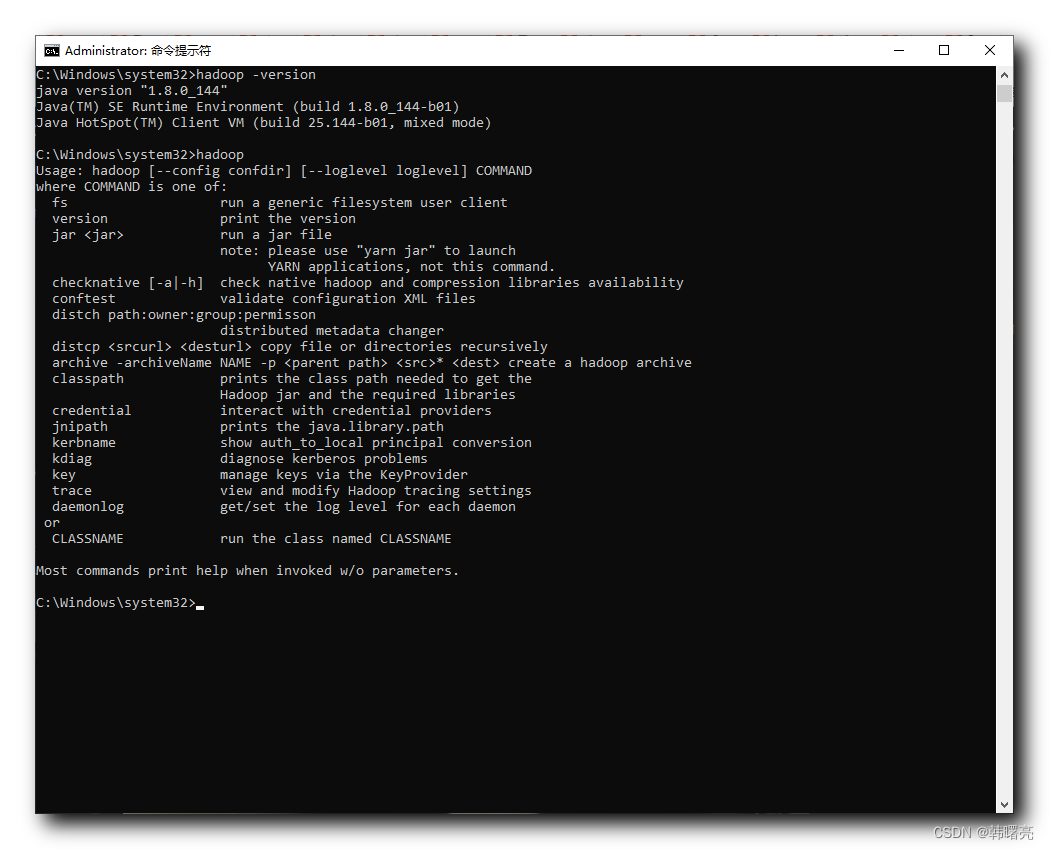

七、验证 hadoop 安装效果

然后在命令行中 , 执行

hadoop -version

验证 hadoop 是否安装完成 ;

c:\windows\system32>hadoop -version

java version "1.8.0_144"

java(tm) se runtime environment (build 1.8.0_144-b01)

java hotspot(tm) client vm (build 25.144-b01, mixed mode)

c:\windows\system32>hadoop

usage: hadoop [--config confdir] [--loglevel loglevel] command

where command is one of:

fs run a generic filesystem user client

version print the version

jar <jar> run a jar file

note: please use "yarn jar" to launch

yarn applications, not this command.

checknative [-a|-h] check native hadoop and compression libraries availability

conftest validate configuration xml files

distch path:owner:group:permisson

distributed metadata changer

distcp <srcurl> <desturl> copy file or directories recursively

archive -archivename name -p <parent path> <src>* <dest> create a hadoop archive

classpath prints the class path needed to get the

hadoop jar and the required libraries

credential interact with credential providers

jnipath prints the java.library.path

kerbname show auth_to_local principal conversion

kdiag diagnose kerberos problems

key manage keys via the keyprovider

trace view and modify hadoop tracing settings

daemonlog get/set the log level for each daemon

or

classname run the class named classname

most commands print help when invoked w/o parameters.

c:\windows\system32>

发表评论