7月4日,腾讯混元文生图大模型(混元dit)宣布开源小显存版本,仅需6g显存即可运行,对使用个人电脑本地部署的开发者十分友好,该版本与lora、controlnet等插件,都已适配至diffusers库;并新增对kohya图形化界面的支持,让开发者可以低门槛地训练个性化lora模型;同时,混元dit模型升级至1.2版本,在图片质感与构图方面均有所提升。

此外,腾讯宣布混元文生图打标模型”混元captioner“正式对外开源。该模型支持中英文双语,针对文生图场景进行专门优化,可帮助开发者快速制作高质量的文生图数据集。

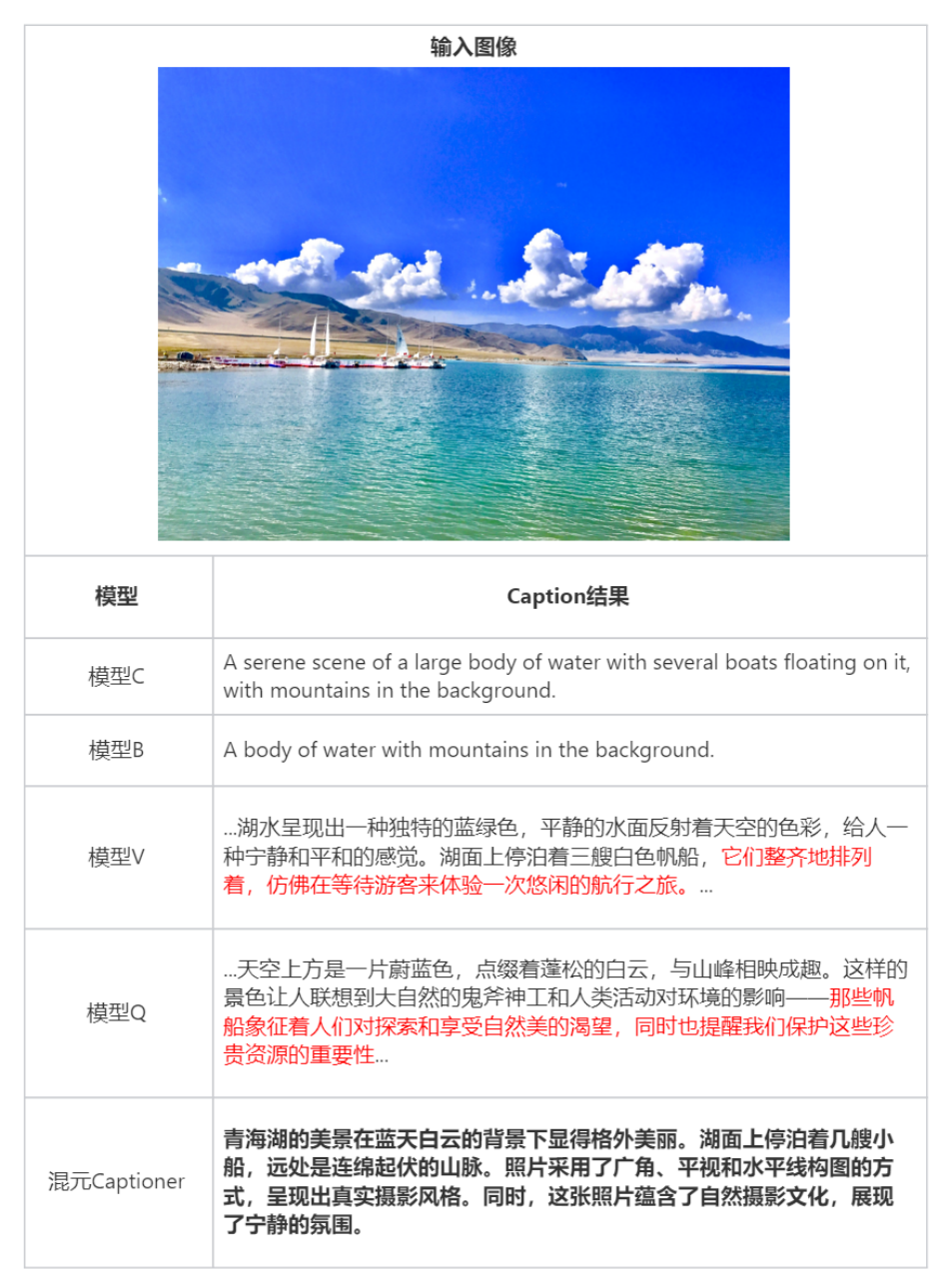

相比起业界的开源打标模型,混元captioner模型能更好的理解与表达中文语义,输出的图片描述更为结构化、完整和准确,并能精准识别出常见知名人物与地标。模型还支持开发者自行补充和导入个性化的背景知识。

混元captioner模型开源之后,全球的文生图研究者、数据标注人员,均可使用混元captioner高效地提升自身图像描述质量,生成更全面、更准确的图片描述,提升模型效果。混元captioner生成的数据集不仅能用于训练基于混元dit的模型,亦可用于其他视觉模型训练。

模型易用性再提升,个人电脑可轻松运行

腾讯混元dit模型宣布了三大更新:推出小显存版本与kohya训练界面,并升级至1.2版本,进一步降低使用门槛的同时提升图片质量。

基于dit架构的文生图模型生成图片质感更佳,但对显存的要求却非常高,让许多开发者望而却步。这也是新版本stable diffusion模型无法快速普及的原因之一。

应广大开发者的需求,混元dit推出小显存版本,最低仅需6g显存即可运行优化推理框架,对使用个人电脑本地部署的开发者非常友好。经过与hugging face合作,小显存版本、lora与controlnet插件,都已经适配到diffusers库中。开发者无需下载原始代码,仅用简单的三行代码仅可调用,大大简化了使用成本。

同时,混元dit宣布接入kohya,让开发者可以低门槛地训练专属lora模型。

kohya是一个开源的、轻量化模型微调训练服务,提供了图形化的用户界面,被广泛用于扩散模型类文生图模型的训练。用户可以通过图形化界面,完成模型的全参精调及lora训练,无需涉及到代码层面的细节。训练好的模型符合kohya生态架构,可以低成本与 webui 等推理界面结合,实现一整套“训练-生图”工作流。

面向文生图、支持中英文,提升数据质量

在提升模型易用性的同时,腾讯混元团队也在开放更多的关键技术,包括此前的训练代码,最新的打标模型混元captioner。

数据集就像ai训练的教材。训练数据集的质量,影响着模型生成内容的效果。因此,文生图开发者往往需要对原始图片进行清晰、全面的标注,制作高质量的数据集,才能训练出来一个语义理解准确、绘画技艺高超的文生图大模型。

借助打标模型,开发者可以快速生成高质量数据集。具体来说,文生图开发者将原始图片集导入混元captioner,后者将生成高质量标注;也可以导入图片与原始描述,利用混元captioner过滤其中的无关信息,并完善和优化图片描述,以提高数据质量。

目前,业界对于图片描述文本的生成,主要使用通用多模态captioner模型,存在描述过于简单或繁琐(与画面描述的无关信息过多)、缺少背景知识导致无法识别知名人物和地标等问题,并且许多模型并非中文原生,中文描述不够精准。

混元captioner对图片描述进行结构化与准确度提升

混元captioner的背景知识更为完善

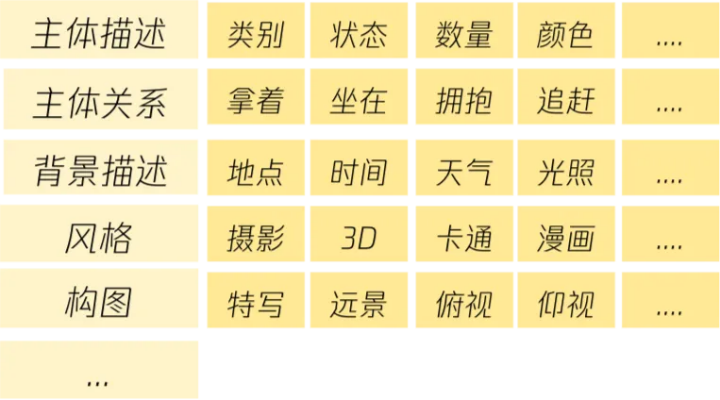

混元captioner模型针对文生图场景专门进行优化:构建了结构化的图片描述体系;并在模型层面,通过注入人工标注、模型输出、公开数据等多种来源提升caption描述的完整性;并注入知名文学作品形象、地标、食物、动物、中国元素与知识等大量背景知识,让模型输出的描述更为准确、完整。

混元captioner模型构建了结构化的图片描述体系

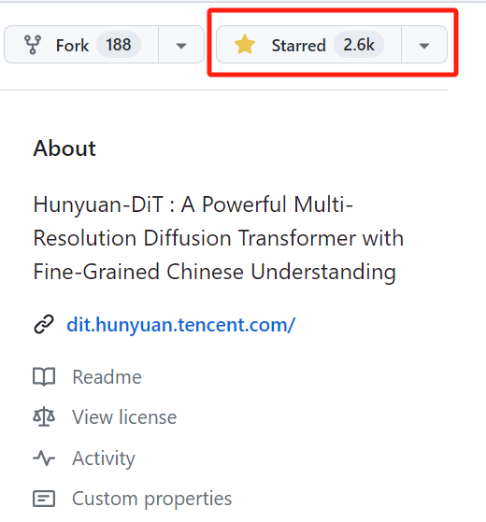

众多开发者关注,成最受欢迎国产dit开源模型

作为首个中文原生dit开源模型,混元dit自全面开源以来,一直持续建设生态。6月,混元dit发布的专属加速库,可将推理效率进一步提升,生图时间缩短75%;并进一步开源了推理代码;发布lora和controlnet等插件。于此同时,模型易用性大幅提升,用户可以通过hugging face diffusers快讯调用混元dit模型及其插件,或基于kohya和comfyui等图形化界面训练与使用混元dit。

目前,在众多开发者的支持下,混元dit发布不到2个月,github star数已经超过2.6k,成为最受欢迎的国产dit开源模型。

腾讯混元开源文生图大模型相关链接:

官网:https://dit.hunyuan.tencent.com/

代码:https://github.com/tencent/hunyuandit

模型:https://huggingface.co/tencent-hunyuan/hunyuandit

论文:https://tencent.github.io/hunyuandit/asset/hunyuan_dit_tech_report_05140553.pdf

发表评论