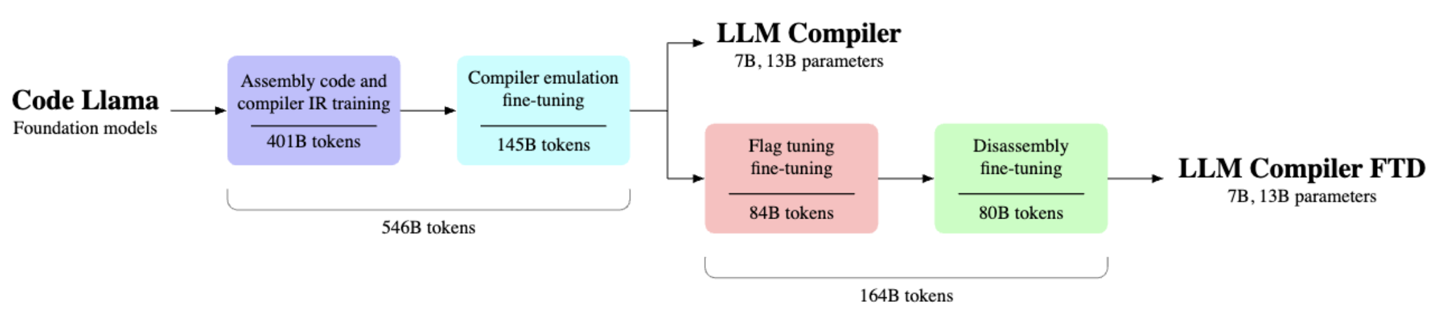

6 月 30 日消息,meta 前天推出了一款名为“llm compiler”的模型,该模型基于 meta 现有的 code llama 打造,主打代码优化,目前相关模型已登陆 hugging face,提供 70 亿参数及 130 亿参数两个版本,允许学术及商业使用,代码网附项目地址如下:点此访问。

meta 认为,尽管业界各大语言模型已在各种编程代码任务中展现了出色的能力,但此类模型在代码优化还有进步空间,目前推出的 llm compiler 模型便是一款专为优化代码任务设计的预训练模型,能够模拟编译器对代码进行优化,或将“已经过优化的代码转换回原本的语言”。

代码网获悉,llm compiler 在 5460 亿个 llvm-ir 和汇编代码标记的庞大语料库上进行了训练,据称能够达到 77% 的“代码优化潜力”,开发者可以自由将相关模型配合其他 ai 模型一起使用,从而改善生成代码的质量。

发表评论