7 月 1 日消息,月之暗面今日官宣 kimi 开放平台上下文缓存(context caching)功能开启公测。官方表示,该技术在 api 价格不变的前提下,可为开发者降低最高 90% 的长文本旗舰大模型使用成本,并提升模型响应速度。

代码网附 kimi 开放平台上下文缓存功能公测详情如下:

技术简介

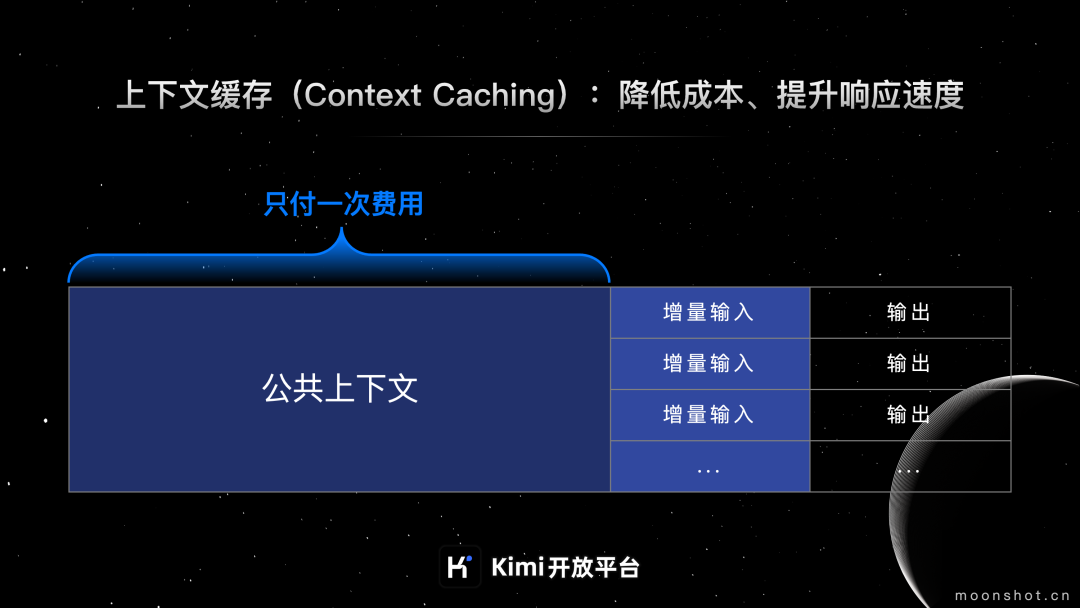

据介绍,上下文缓存是一种数据管理技术,允许系统预先存储会被频繁请求的大量数据或信息。当用户请求相同信息时,系统可以直接从缓存中提供,无需重新计算或从原始数据源中检索。

适用场景

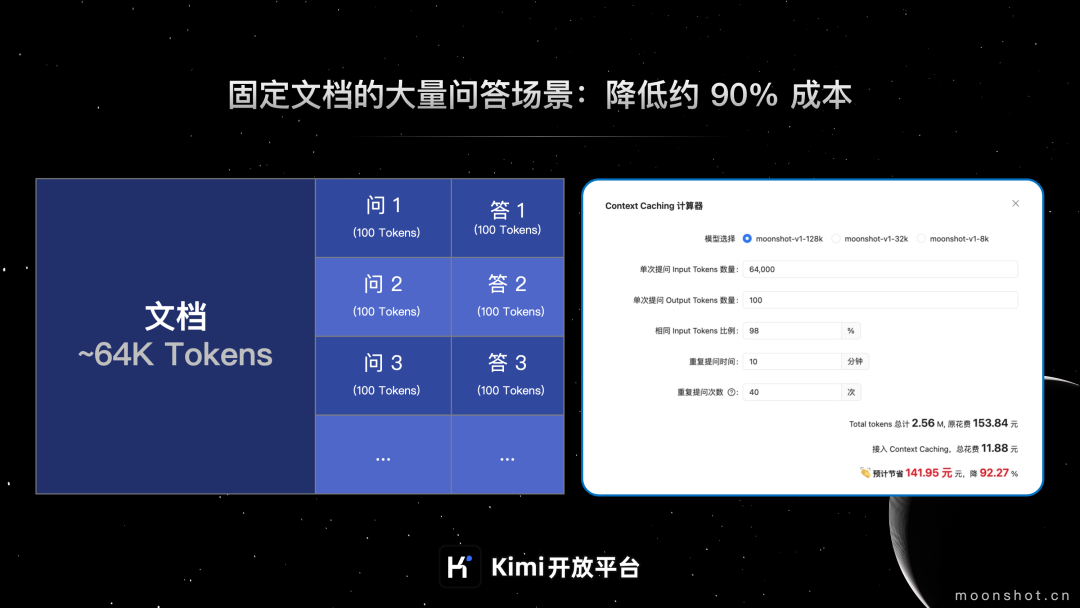

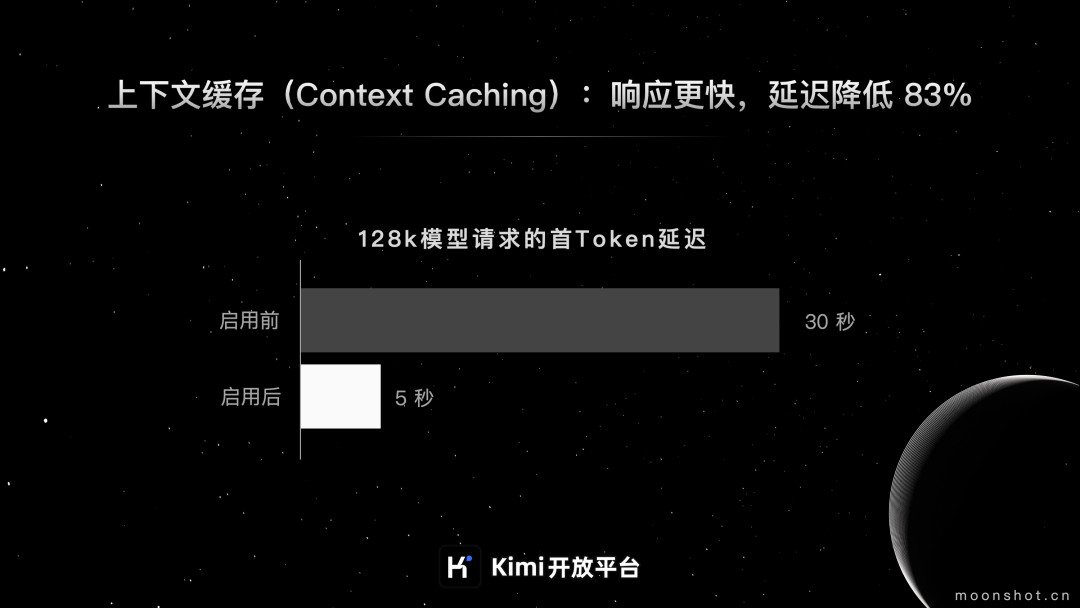

上下文缓存适用于频繁请求,重复引用大量初始上下文场景,可降低长文本模型费用,提高效率。官方表示费用最高降低 90 %,首 token 延迟降低 83%。适用业务场景如下:

提供大量预设内容的 qa bot,例如 kimi api 小助手

针对固定的文档集合的频繁查询,例如上市公司信息披露问答工具

对静态代码库或知识库的周期性分析,例如各类 copilot agent

瞬时流量巨大的爆款 ai 应用,例如哄哄模拟器,llm riddles

交互规则复杂的 agent 类应用等

计费说明

上下文缓存收费模式主要分为以下三个部分:

cache 创建费用

调用 cache 创建接口,成功创建 cache 后,按照 cache 中 tokens 按实际量计费。24 元 / m token

cache 存储费用

cache 存活时间内,按分钟收取 cache 存储费用。10 元 / m token / 分钟

cache 调用费用

cache 调用增量 token 的收费:按模型原价收费

cache 调用次数收费:cache 存活时间内,用户通过 chat 接口请求已创建成功的 cache,若 chat message 内容与存活中的 cache 匹配成功,将按调用次数收取 cache 调用费用。0.02 元 / 次

公测时间和资格说明

公测时间:功能上线后,公测 3 个月,公测期价格可能随时调整。

公测资格:公测期间 context caching 功能优先开放给 tier5 等级用户,其他用户范围放开时间待定。

发表评论