6 月 28 日消息,谷歌公司昨日发布新闻稿,面向全球研究人员和开发人员发布 gemma 2 大语言模型,共有 90 亿参数(9b)和 270 亿参数(27b)两种大小。

gemma 2 大语言模型相比较第一代,推理性能更高、效率更高,并在安全性方面取得了重大进步。

谷歌在新闻稿中表示,gemma 2-27b 模型的性能媲美两倍规模的主流模型,而且只需要一片英伟达 h100 ensor core gpu 或 tpu 主机就能实现这种性能,从而大大降低了部署成本。

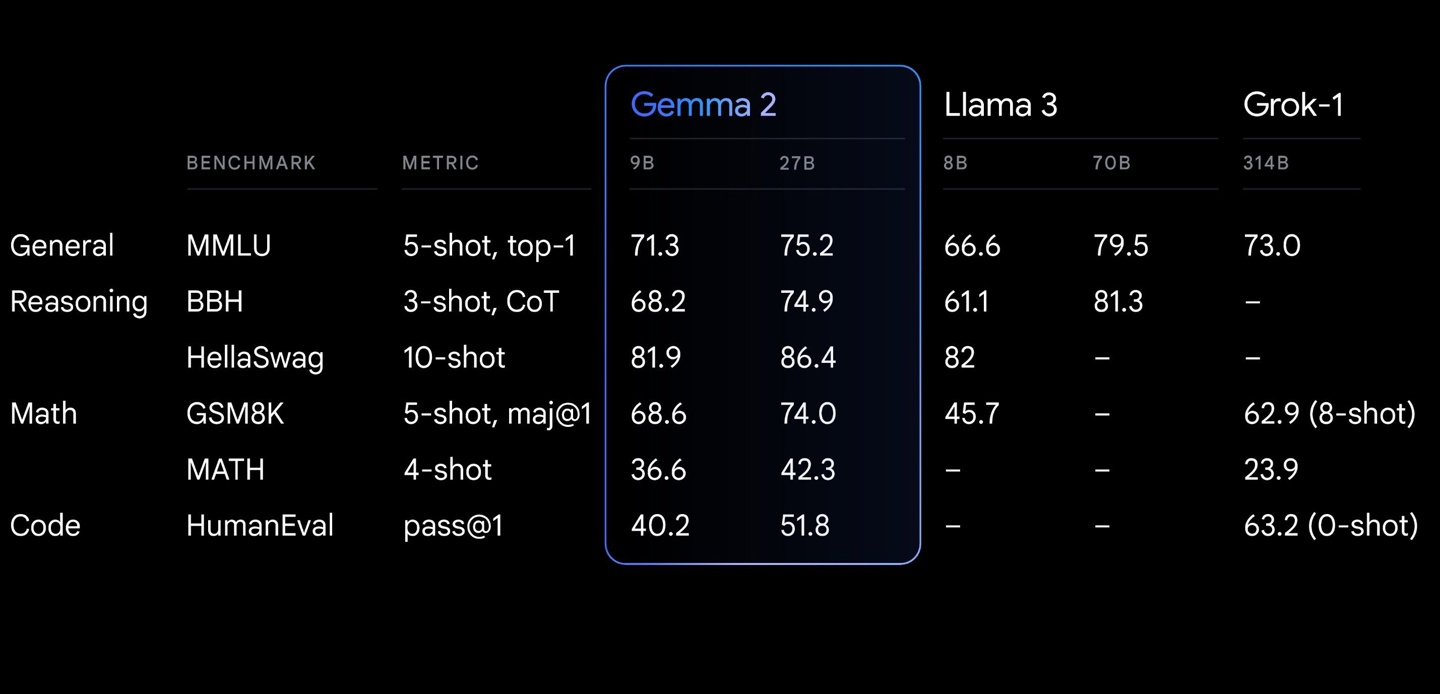

gemma 2-9b 模型优于 llama 3 8b 和其他类似规模的开源模型。谷歌还计划在未来几个月发布参数为 26 亿的 gemma 2 模型,更适合智能手机的人工智能应用场景。

谷歌表示为 gemma 2 重新设计了整体架构,实现卓越的性能和推理效率。代码网附上 gemma 2 主要特点如下:

性能优异:

27b 版本在同规模级别中性能最佳,甚至比两倍于其尺寸的机型更具竞争力。9b 版本的性能在同类产品中也处于领先地位,超过了 llama 3 8b 和其他同规模的开放模型。

效率和成本:

27b gemma 2 模型可在单个谷歌云 tpu 主机、英伟达 a100 80gb tensor core gpu 或英伟达 h100 tensor core gpu 上以全精度高效运行推理,在保持高性能的同时大幅降低成本。这使得人工智能部署更容易实现,预算也更合理。

跨硬件快速推理

gemma 2 经过优化,可在各种硬件(从功能强大的游戏笔记本电脑和高端台式机到基于云的设置)上以惊人的速度运行。

在 google ai studio 中尝试全精度的 gemma 2,在 cpu 上使用 gemma.cpp 的量化版本解锁本地性能,或通过 hugging face transformers 在配备 nvidia rtx 或 geforce rtx 的家用电脑上进行尝试。

发表评论