6 月 17 日消息,最新研究称,越来越多的人难以在图灵测试中区分 gpt-4 和人类。

据代码网了解,“图灵测试”由计算机科学家艾伦・图灵在 1950 年提出,又被称为“模仿游戏”。测试的标准是机器能否像人类一样进行对话,让对方误以为其是真人。

加州大学圣地亚哥分校的研究人员招募了 500 名参与者,让他们与四位“对话者”进行五分钟的交流,这四位“对话者”分别是真人、上世纪 60 年代的初代聊天机器人 eliza、以及驱动聊天机器人 chatgpt 的 gpt-3.5 和 gpt-4。参与者在对话结束后需判断对方是人还是机器。

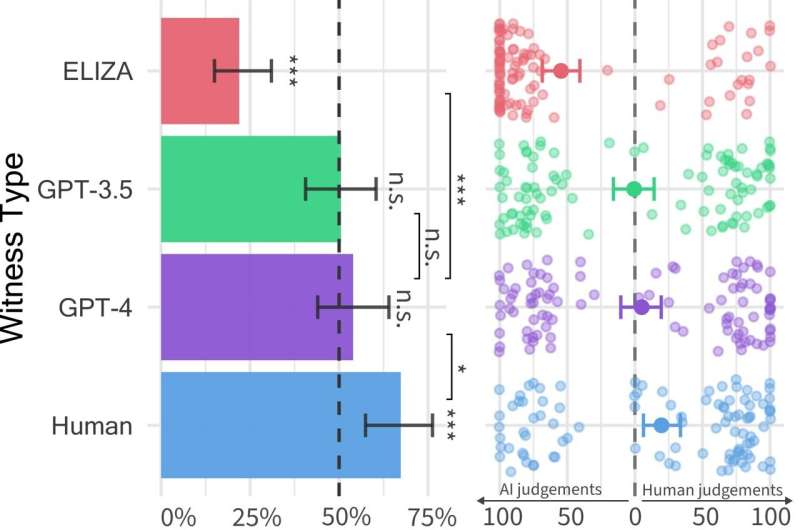

这项测试的结果发表于预印网站 arxiv 上,结果显示,有 54% 的参与者将 gpt-4 误认为真人。相比之下,预先设定好回复的 eliza 只有 22% 的人将其认作真人,gpt-3.5 则为 50%,而人类对话者被正确辨认的比例则为 67%。

研究人员指出,图灵测试过于简单,对话的风格和情感因素在测试中扮演着比传统智能认知更重要的角色。

电气和电子工程师协会 (ieee) 的人工智能研究员内尔・沃森 (nell watson) 表示,单纯的智力并不能代表一切,真正重要的是足够智能地理解情境、他人的技能并具备同理心将这些要素结合起来。能力仅仅是 ai 价值的一部分,理解人类的价值观、偏好和界限也同样重要,正是这些品质才能让 ai 成为我们生活中忠诚可靠的管家。

沃森还提到,这项研究对未来的人机交互提出了挑战,人们将会对互动对象的真实性愈发疑虑,尤其是在涉及敏感话题时。同时,这项研究也凸显了 gpt 时代人工智能的巨大进步。

发表评论