6 月 7 日消息,腾讯混元团队联合中山大学、香港科技大学联合推出全新图生视频模型“follow-your-pose-v2”,相关成果已经发表在 arxiv 上(代码网附 doi:10.48550/arxiv.2406.03035)。

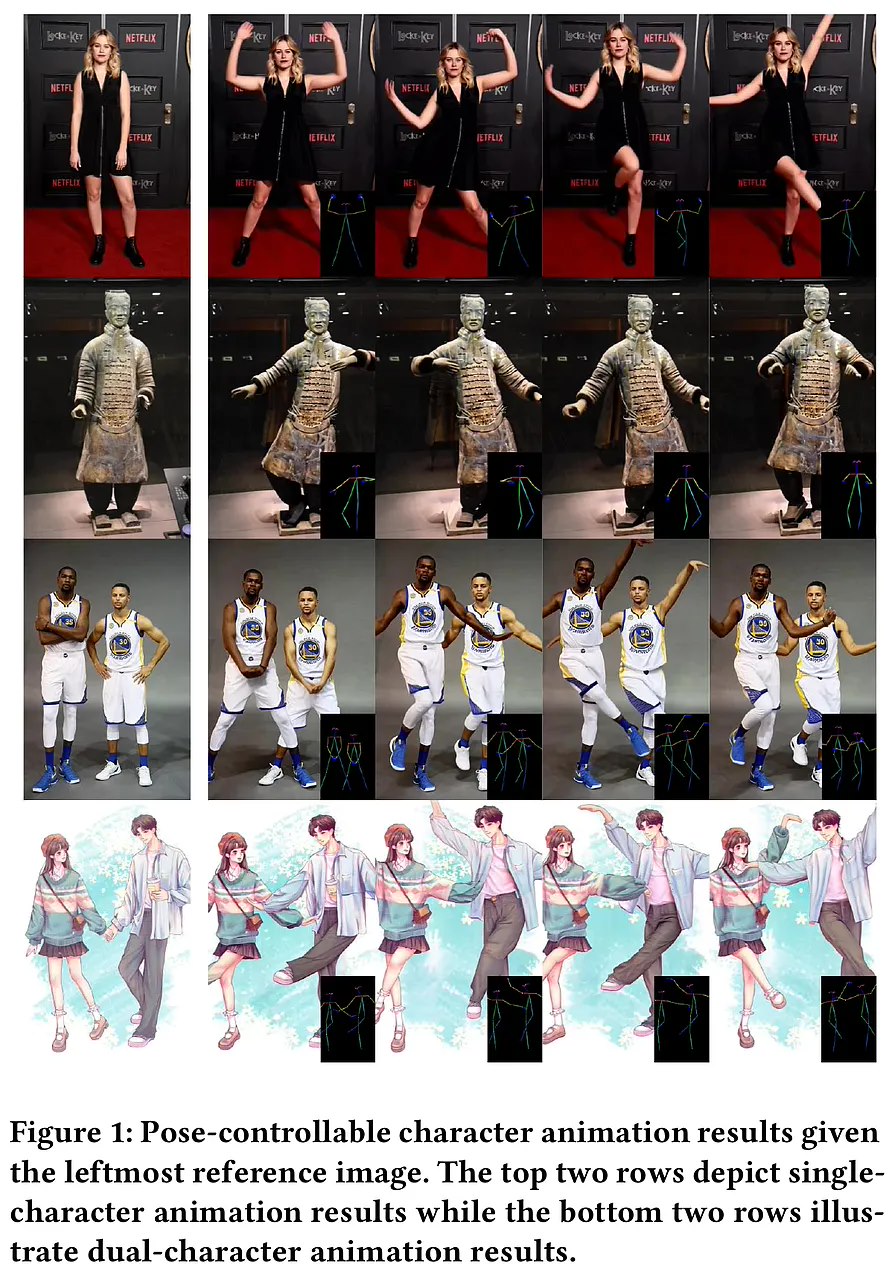

据介绍,“follow-your-pose-v2”只需要输入一张人物图片和一段动作视频,就可以让图片上的人跟随视频上的动作动起来,生成视频长度可达 10 秒。

与此前推出的模型相比,“follow-your-pose-v2”可以在推理耗时更少的情况下,支持多人视频动作生成。

此外,该模型具备较强的泛化能力,无论输入人物是什么年龄、服装,背景如何杂乱,动作视频的动作如何复杂,都能生成出高质量的视频。

正如代码网前一天的报道,腾讯已经公布了针对腾讯混元文生图开源大模型(混元 dit)的加速库,号称大幅提升推理效率,生图时间缩短 75%。

官方表示,混元 dit 模型的使用门槛也大幅降低,用户可以基于 comfyui 的图形化界面使用腾讯混元文生图模型能力。

发表评论