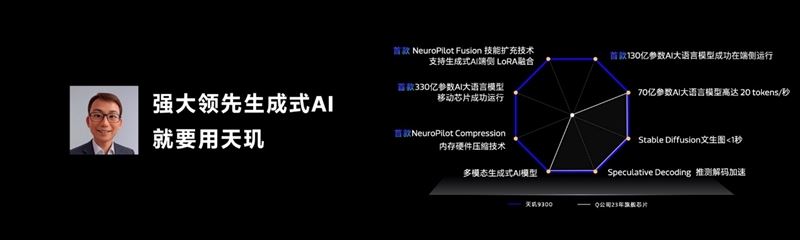

二、登上端侧ai新高度:330亿参数大模型轻松搞定

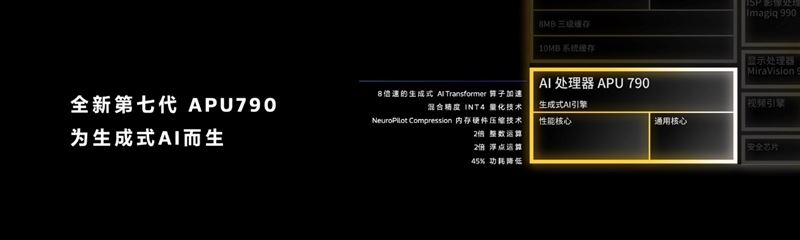

天玑9300集成了全新的第七代apu 790 ai处理器,行业首款搭载了硬件生成式ai引擎,同时集成性能核心、通用核心,全链路针对生成式ai进行优化,整数、浮点运算性能都提升了2倍,功耗则降低了45%。

天玑9300目前已经成功运行330亿参数的大模型,相比骁龙8 gen3 100亿遥遥领先,而且与vivo深度合作,实现了70亿参数大语言模型端侧落地、130亿参数大语言模型端侧运行。

天玑9300重点解决了端侧ai三大痛点:内存限制、生成速度偏慢、大模型应用类型受限。

针对手机内存容量限制,天玑9300支持内存硬件压缩技术neuropilot compression,结合大语言模型的int4混合精度量化,将大模型的内存占用大幅减少了61%。

比如它还支持了330亿参数大模型,原本需要至少13gb内存,因此对于16gb内存手机来说就完全不够用。

而在联发科的调教下,只需5gb就够了,加上android系统本身占用4gb、app应用保活需要6gb,甚至还能富余1gb的自由空间。

针对生成速度问题,天玑9300深度适配transformer模型,优化softmax+layernorm算子,处理速度提升多达8倍。

此外,天玑9300支持行业速度最快的lpddr5t 9600mbps内存,可提供77gb/s带宽,保证ai运算无瓶颈。

正是这些设计,使得天玑9300 70亿参数大模型生成速度达到了每秒20 tokens,stable diffusion 1.5文生图速度可以做到1秒之内。

针对大模型数量在端侧受限的问题,天玑9300拥有行业领先的lora(低秩自适应)融合,并首次搭载生成式ai端侧“技能扩充”技术neuropilot fusioin,为基础大模型提供更全面的端侧能力,实现多样化的本地内容生成。

以上提及的很多技术和优化,都是联发科neuropilot ai开发平台的一部分,可以为开发者提供端侧生成式ai落地的一站式资源,以及诸多案例分享。

目前,联发科端侧生成式ai已有20多个合作伙伴,包括谷歌、meta、百度、百川、抖音、快手、虎牙、爱奇艺、美图秀秀等等。

发表评论