概述

本文将介绍如何使用 nginx ingress 实现金丝雀发布,从使用场景分析,到用法详解,再到上手实践。

前提条件

集群中需要部署 nginx ingress 作为 ingress controller,并且对外暴露了统一的流量入口,参考 nginx ingress on tke 部署最佳实践。

nginx ingress 可以用在哪些发布场景 ?

使用 nginx ingress 来实现金丝雀发布,可以用在哪些场景呢?这个主要看使用什么策略进行流量切分,目前 nginx ingress 支持基于 header、cookie 和服务权重这 3 种流量切分的策略,基于它们可以实现以下两种发布场景。

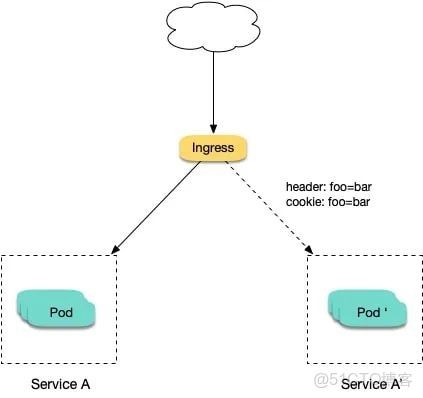

场景一: 将新版本灰度给部分用户 (header cookie)

假设线上运行了一套对外提供 7 层服务的 service a 服务,后来开发了个新版本 service a' 想要上线,但又不想直接替换掉原来的 service a,希望先灰度一小部分用户,等运行一段时间足够稳定了再逐渐全量上线新版本,最后平滑下线旧版本。

这个时候就可以利用 nginx ingress 基于 header 或 cookie 进行流量切分的策略来发布,业务使用 header 或 cookie 来标识不同类型的用户,我们通过配置 ingress 来实现让带有指定 header 或 cookie 的请求被转发到新版本,其它的仍然转发到旧版本,从而实现将新版本灰度给部分用户:

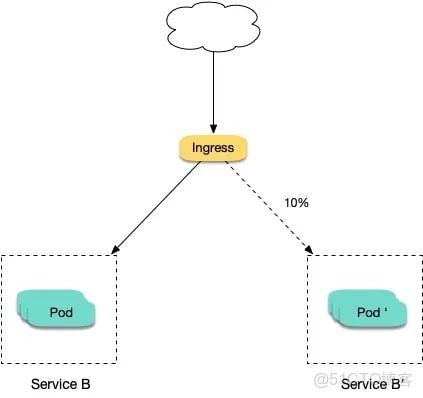

场景二: 切一定比例的流量给新版本(权重)

假设线上运行了一套对外提供 7 层服务的 service b 服务,后来修复了一些问题,需要灰度上线一个新版本 service b',但又不想直接替换掉原来的 service b,而是让先切 10% 的流量到新版本,等观察一段时间稳定后再逐渐加大新版本的流量比例直至完全替换旧版本,最后再滑下线旧版本,从而实现切一定比例的流量给新版本:

注解说明

我们通过给 ingress 资源指定 nginx ingress 所支持的一些 annotation 可以实现金丝雀发布,需要给服务创建两个 ingress,一个正常的 ingress,另一个是带 nginx.ingress.kubernetes.io/canary: "true" 这个固定的 annotation 的 ingress,我们姑且称它为 canary ingress,一般代表新版本的服务,结合另外针对流量切分策略的 annotation 一起配置即可实现多种场景的金丝雀发布,以下对这些 annotation 详细介绍下:

- nginx.ingress.kubernetes.io/canary-by-header: 表示如果请求头中包含这里指定的 header 名称,并且值为 always 的话,就将该请求转发给该 ingress 定义的对应后端服务;如果值为 never 就不转发,可以用于回滚到旧版;如果是其它值则忽略该 annotation。

- nginx.ingress.kubernetes.io/canary-by-header-value: 这个可以作为 canary-by-header的补充,允许指定请求头的值可以自定义成其它值,不再只能是 always 或 never;当请求头的值命中这里的自定义值时,请求将会转发给该 ingress 定义的对应后端服务,如果是其它值则将会忽略该 annotation。

- nginx.ingress.kubernetes.io/canary-by-header-pattern: 这个与上面的 canary-by-header-value 类似,唯一的区别是它是用正则表达式对来匹配请求头的值,而不是只固定某一个值;需要注意的是,如果它与 canary-by-header-value 同时存在,这个 annotation 将会被忽略。

- nginx.ingress.kubernetes.io/canary-by-cookie: 这个与 canary-by-header 类似,只是这个用于 cookie,同样也是只支持 always 和 never 的值。

- nginx.ingress.kubernetes.io/canary-weight: 表示 canary ingress 所分配流量的比例的百分比,取值范围 [0-100],比如设置为 10,意思是分配 10% 的流量给 canary ingress 对应的后端服务。

上面的规则会按优先顺序进行评估,优先顺序如下:canary-by-header -> canary-by-cookie -> canary-weight

注意: 当 ingress 被标记为 canary ingress 时,除了nginx.ingress.kubernetes.io/load-balance和 nginx.ingress.kubernetes.io/upstream-hash-by 之外,所有其他非 canary 注释都将被忽略。

上手实践

下面我们给出一些例子,让你快速上手 nginx ingress 的金丝雀发布,环境为 tke 集群。

使用 yaml 创建资源

本文的示例将使用 yaml 的方式部署工作负载和创建 service,有两种操作方式。

方式一:在 tke 或 eks 控制台右上角点击 yaml 创建资源,然后将本文示例的 yaml 粘贴进去:

方式二:将示例的 yaml 保存成文件,然后使用 kubectl 指定 yaml 文件来创建,如: kubectl apply -f xx.yaml 。

部署两个版本的服务

这里以简单的 nginx 为例,先部署一个 v1 版本:

apiversion: apps/v1

kind: deployment

metadata:

name: nginx-v1

spec:

replicas: 1

selector:

matchlabels:

app: nginx

version: v1

template:

metadata:

labels:

app: nginx

version: v1

spec:

containers:

- name: nginx

image: "openresty/openresty:centos"

ports:

- name: http

protocol: tcp

containerport: 80

volumemounts:

- mountpath: /usr/local/openresty/nginx/conf/nginx.conf

name: config

subpath: nginx.conf

volumes:

- name: config

configmap:

name: nginx-v1

---

apiversion: v1

kind: configmap

metadata:

labels:

app: nginx

version: v1

name: nginx-v1

data:

nginx.conf: |-

worker_processes 1;

events {

accept_mutex on;

multi_accept on;

use epoll;

worker_connections 1024;

}

http {

ignore_invalid_headers off;

server {

listen 80;

location / {

access_by_lua '

local header_str = ngx.say("nginx-v1")

';

}

}

}

---

apiversion: v1

kind: service

metadata:

name: nginx-v1

spec:

type: clusterip

ports:

- port: 80

protocol: tcp

name: http

selector:

app: nginx

version: v1再部署一个 v2 版本:

apiversion: apps/v1

kind: deployment

metadata:

name: nginx-v2

spec:

replicas: 1

selector:

matchlabels:

app: nginx

version: v2

template:

metadata:

labels:

app: nginx

version: v2

spec:

containers:

- name: nginx

image: "openresty/openresty:centos"

ports:

- name: http

protocol: tcp

containerport: 80

volumemounts:

- mountpath: /usr/local/openresty/nginx/conf/nginx.conf

name: config

subpath: nginx.conf

volumes:

- name: config

configmap:

name: nginx-v2

---

apiversion: v1

kind: configmap

metadata:

labels:

app: nginx

version: v2

name: nginx-v2

data:

nginx.conf: |-

worker_processes 1;

events {

accept_mutex on;

multi_accept on;

use epoll;

worker_connections 1024;

}

http {

ignore_invalid_headers off;

server {

listen 80;

location / {

access_by_lua '

local header_str = ngx.say("nginx-v2")

';

}

}

}

---

apiversion: v1

kind: service

metadata:

name: nginx-v2

spec:

type: clusterip

ports:

- port: 80

protocol: tcp

name: http

selector:

app: nginx

version: v2可以在控制台看到部署的情况:

再创建一个 ingress,对外暴露服务,指向 v1 版本的服务:

apiversion: extensions/v1beta1

kind: ingress

metadata:

name: nginx

annotations:

kubernetes.io/ingress.class: nginx

spec:

rules:

- host: canary.example.com

http:

paths:

- backend:

servicename: nginx-v1

serviceport: 80

path: /访问验证一下:

$ curl -h "host: canary.example.com" http://external-ip # external-ip 替换为 nginx ingress 自身对外暴露的 ip nginx-v1

基于 header 的流量切分

创建 canary ingress,指定 v2 版本的后端服务,且加上一些 annotation,实现仅将带有名为 region 且值为 cd 或 sz 的请求头的请求转发给当前 canary ingress,模拟灰度新版本给成都和深圳地域的用户:

apiversion: extensions/v1beta1

kind: ingress

metadata:

annotations:

kubernetes.io/ingress.class: nginx

nginx.ingress.kubernetes.io/canary: "true"

nginx.ingress.kubernetes.io/canary-by-header: "region"

nginx.ingress.kubernetes.io/canary-by-header-pattern: "cd|sz"

name: nginx-canary

spec:

rules:

- host: canary.example.com

http:

paths:

- backend:

servicename: nginx-v2

serviceport: 80

path: /测试访问:

$ curl -h "host: canary.example.com" -h "region: cd" http://external-ip # external-ip 替换为 nginx ingress 自身对外暴露的 ip nginx-v2 $ curl -h "host: canary.example.com" -h "region: bj" http://external-ip nginx-v1 $ curl -h "host: canary.example.com" -h "region: sz" http://external-ip nginx-v2 $ curl -h "host: canary.example.com" http://external-ip nginx-v1

可以看到,只有 header region 为 cd 或 sz 的请求才由 v2 版本服务响应。

基于 cookie 的流量切分

与前面 header 类似,不过使用 cookie 就无法自定义 value 了,这里以模拟灰度成都地域用户为例,仅将带有名为 user_from_cd 的 cookie 的请求转发给当前 canary ingress 。先删除前面基于 header 的流量切分的 canary ingress,然后创建下面新的 canary ingress:

apiversion: extensions/v1beta1

kind: ingress

metadata:

annotations:

kubernetes.io/ingress.class: nginx

nginx.ingress.kubernetes.io/canary: "true"

nginx.ingress.kubernetes.io/canary-by-cookie: "user_from_cd"

name: nginx-canary

spec:

rules:

- host: canary.example.com

http:

paths:

- backend:

servicename: nginx-v2

serviceport: 80

path: /测试访问:

$ curl -s -h "host: canary.example.com" --cookie "user_from_cd=always" http://external-ip # external-ip 替换为 nginx ingress 自身对外暴露的 ip nginx-v2 $ curl -s -h "host: canary.example.com" --cookie "user_from_bj=always" http://external-ip nginx-v1 $ curl -s -h "host: canary.example.com" http://external-ip nginx-v1

可以看到,只有 cookie user_from_cd 为 always 的请求才由 v2 版本的服务响应。

基于服务权重的流量切分

基于服务权重的 canary ingress 就简单了,直接定义需要导入的流量比例,这里以导入 10% 流量到 v2 版本为例 (如果有,先删除之前的 canary ingress):

apiversion: extensions/v1beta1

kind: ingress

metadata:

annotations:

kubernetes.io/ingress.class: nginx

nginx.ingress.kubernetes.io/canary: "true"

nginx.ingress.kubernetes.io/canary-weight: "10"

name: nginx-canary

spec:

rules:

- host: canary.example.com

http:

paths:

- backend:

servicename: nginx-v2

serviceport: 80

path: /测试访问:

$ for i in {1..10}; do curl -h "host: canary.example.com" http://external-ip; done;

nginx-v1

nginx-v1

nginx-v1

nginx-v1

nginx-v1

nginx-v1

nginx-v2

nginx-v1

nginx-v1

nginx-v1可以看到,大概只有十分之一的几率由 v2 版本的服务响应,符合 10% 服务权重的设置。

存在的缺陷

虽然我们使用 nginx ingress 实现了几种不同姿势的金丝雀发布,但还存在一些缺陷:

- 相同服务的 canary ingress 只能定义一个,所以后端服务最多支持两个版本。

- ingress 里必须配置域名,否则不会有效果。

- 即便流量完全切到了 canary ingress 上,旧版服务也还是必须存在,不然会报错。

总结

本文全方位总结了 nginx ingress 的金丝雀发布用法,虽然 nginx ingress 在金丝雀发布这方面的能力有限,并且还存在一些缺陷,但基本也能覆盖一些常见的场景,如果集群中使用了 nginx ingress,并且发布的需求也不复杂,可以考虑使用这种方案。

到此这篇关于使用nginx ingress实现金丝雀发布的文章就介绍到这了,更多相关nginx ingress金丝雀发布内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论