torch.clamp 是 pytorch 中的一个非常有用的函数,它可以将张量的每个元素限制在一个指定的范围内,超出范围的元素将被裁剪为边界值。

函数签名:

torch.clamp(input, min=none, max=none, out=none)

参数说明:

input:输入张量。min:下限值,所有小于该值的元素会被置为该值。如果设置为none,则不对下限进行裁剪。max:上限值,所有大于该值的元素会被置为该值。如果设置为none,则不对上限进行裁剪。out:输出张量,指定裁剪后的结果存放的位置。如果不指定,默认会创建一个新的张量来存放结果。

返回值:

- 返回一个新的张量,其中所有元素都被限制在

[min, max]范围内。如果元素超出了这个范围,就会被替换为相应的边界值。

功能描述:

- 如果没有设置

min或max,则只会进行一个方向的裁剪。 - 这个操作并不会改变原始的

input张量,而是返回一个新的张量。

用法示例:

1. 基本示例:限制张量在指定范围内

import torch # 创建一个张量 tensor = torch.tensor([-1.0, 2.0, 3.0, 4.0, 5.0]) # 限制张量元素在 [0, 4] 范围内 clamped_tensor = torch.clamp(tensor, min=0, max=4) print(clamped_tensor)

输出:

tensor([0.0, 2.0, 3.0, 4.0, 4.0])

在这个例子中,所有小于 0 的元素被替换为 0,所有大于 4 的元素被替换为 4。

2. 只有上限裁剪:只限制最大值

import torch # 创建一个张量 tensor = torch.tensor([-1.0, 2.0, 3.0, 4.0, 5.0]) # 限制张量元素不超过 4 clamped_tensor = torch.clamp(tensor, max=4) print(clamped_tensor)

输出:

tensor([-1.0, 2.0, 3.0, 4.0, 4.0])

3. 只有下限裁剪:只限制最小值

import torch # 创建一个张量 tensor = torch.tensor([-1.0, 2.0, 3.0, 4.0, 5.0]) # 限制张量元素不小于 0 clamped_tensor = torch.clamp(tensor, min=0) print(clamped_tensor)

输出:

tensor([0.0, 2.0, 3.0, 4.0, 5.0])

4. 直接修改原始张量:

import torch # 创建一个张量 tensor = torch.tensor([-1.0, 2.0, 3.0, 4.0, 5.0]) # 使用 out 参数来修改原始张量 torch.clamp(tensor, min=0, max=4, out=tensor) print(tensor)

输出:

tensor([0.0, 2.0, 3.0, 4.0, 4.0])

在这个示例中,tensor 张量会被就地修改(通过 out 参数)。原始张量的内容被更新为裁剪后的结果。

5. 处理浮动的张量

torch.clamp 也可以应用于浮动的张量数据,以下是一个浮动张量的例子:

import torch # 创建一个浮动张量 tensor = torch.tensor([0.5, 1.2, 2.5, -0.3, 3.8]) # 限制在 [0, 3] 之间 clamped_tensor = torch.clamp(tensor, min=0, max=3) print(clamped_tensor)

输出:

tensor([0.5000, 1.2000, 2.5000, 0.0000, 3.0000])

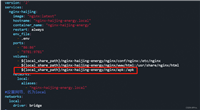

6. 与激活函数结合的应用(例如 relu):

torch.clamp 在一些常见激活函数(如 relu)中被广泛使用:

import torch # 创建一个张量 tensor = torch.tensor([-0.5, 0.2, -1.0, 0.8]) # relu 激活函数(将小于0的值置为0) clamped_tensor = torch.clamp(tensor, min=0) print(clamped_tensor)

输出:

tensor([0.0000, 0.2000, 0.0000, 0.8000])

性能注意事项:

torch.clamp是一个 逐元素 操作,因此会遍历整个张量,可能在处理大量数据时会带来一定的计算开销。- 如果你的张量是非常大的,考虑在

min和max参数中使用适当的值来避免不必要的计算,减少内存和时间开销。

小结:

torch.clamp是 pytorch 中用于将张量元素限制在一个范围内的函数,支持设置下限、上限或两者。- 它可以用于各种场景,比如激活函数(如 relu),数据预处理,或者某些需要限制数据范围的算法。

- 通过合理使用

torch.clamp,可以有效防止梯度爆炸或数据溢出等问题。

到此这篇关于pytorch 中torch.clamp函数使用详解和实战示例 的文章就介绍到这了,更多相关pytorch torch.clamp函数使用内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论