scrapy作为python生态中最强大的爬虫框架之一,其官方文档的"common practices"章节总结了多个高频使用场景的解决方案。本文将深入解析如何通过脚本控制爬虫、多爬虫协同工作、分布式部署策略以及反反爬技巧,帮助开发者突破基础使用限制。

一、脚本化运行scrapy爬虫

1.1 使用crawlerprocess(单进程方案)

from scrapy.crawler import crawlerprocess

from myproject.spiders.my_spider import myspider

# 方式1:直接定义设置

process = crawlerprocess({

'feeds': {

'output.json': {'format': 'json'},

}

})

process.crawl(myspider)

process.start() # 阻塞直到爬取完成

# 方式2:加载项目配置

from scrapy.utils.project import get_project_settings

process = crawlerprocess(get_project_settings())

process.crawl('followall', domain='scrapy.org') # 通过名称调用

process.start()关键点:

- 自动管理twisted reactor生命周期

- 内置日志和信号处理

- 适合独立脚本开发

1.2 使用crawlerrunner(高级控制)

from twisted.internet import reactor from scrapy.crawler import crawlerrunner configure_logging() runner = crawlerrunner() d = runner.crawl(myspider) d.addboth(lambda _: reactor.stop()) reactor.run() # 需手动管理reactor

适用场景:

- 已有twisted应用集成

- 需要自定义reactor配置

- 多爬虫顺序执行控制

二、多爬虫协同工作策略

2.1 并行执行方案

process = crawlerprocess(get_project_settings()) process.crawl(myspider1) process.crawl(myspider2) process.start() # 同时启动两个爬虫

2.2 顺序执行方案(deferred链式调用)

@defer.inlinecallbacks

def run_spiders():

yield runner.crawl(myspider1)

yield runner.crawl(myspider2)

reactor.callwhenrunning(run_spiders)

reactor.run()注意事项:

- 同进程内不同爬虫的

spider_loader_class等设置无法动态修改 - 共享资源需通过中间件协调(如自定义downloader middleware)

三、分布式爬取解决方案

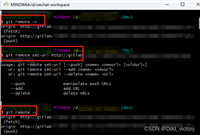

3.1 scrapyd集群部署

- 多节点部署scrapyd服务

- 使用api分发任务:

curl http://scrapy1:6800/schedule.json \ -d project=myproject \ -d spider=spider1 \ -d part=1

3.2 url分区策略

http://example.com/urls-to-crawl/spider1/part1.list http://example.com/urls-to-crawl/spider1/part2.list

优势:

- 水平扩展爬取能力

- 简单实现负载均衡

四、反反爬实战技巧

4.1 请求伪装方案

| 技术手段 | 实现示例 |

|---|---|

| user-agent轮换 | user_agent_list = [...] + 中间件 |

| ip代理池 | scrapy-redis + proxymiddleware |

| 请求间隔控制 | download_delay = 2 |

4.2 高级防护应对

- 验证码处理:接入打码平台或ocr服务

- 行为模拟:通过selenium处理动态交互

- 指纹伪装:修改默认请求头和tcp指纹

警告:大规模爬取前需评估法律风险,建议优先使用官方api

五、性能优化建议

- 并发控制:调整

concurrent_requests和download_delay - 缓存机制:启用

httpcache_enabled = true - 去重优化:自定义

dupefilter_class实现布隆过滤器 - 资源监控:通过scrapy stats collector实时观测性能指标

掌握scrapy的高级用法能显著提升爬虫开发效率。从单机脚本到分布式集群,从基础反反爬到复杂场景应对,开发者需根据实际需求选择合适方案。建议结合scrapy官方文档持续学习,并通过实际项目积累经验。

扩展阅读:

- scrapy官方文档 - common practices

- scrapy-redis分布式实现

- twisted网络编程指南

到此这篇关于scrapy从脚本运行到分布式爬取的技巧(进阶实践指南)的文章就介绍到这了,更多相关scrapy分布式爬取内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

发表评论